Το OpenAI προτείνει έναν νέο τρόπο χρήσης του GPT-4 για την εποπτεία περιεχομένου

Η OpenAI ισχυρίζεται ότι έχει αναπτύξει έναν τρόπο να χρησιμοποιεί το GPT-4, το ναυαρχίδα του μοντέλου παρ

αγωγή

ς τεχνητής νοημοσύνης, για τον έλεγχο περιεχομένου — ελαφρύνοντας το βάρος στις ανθρώπινες ομάδες.

Αναλυτικά στο α

Θέση

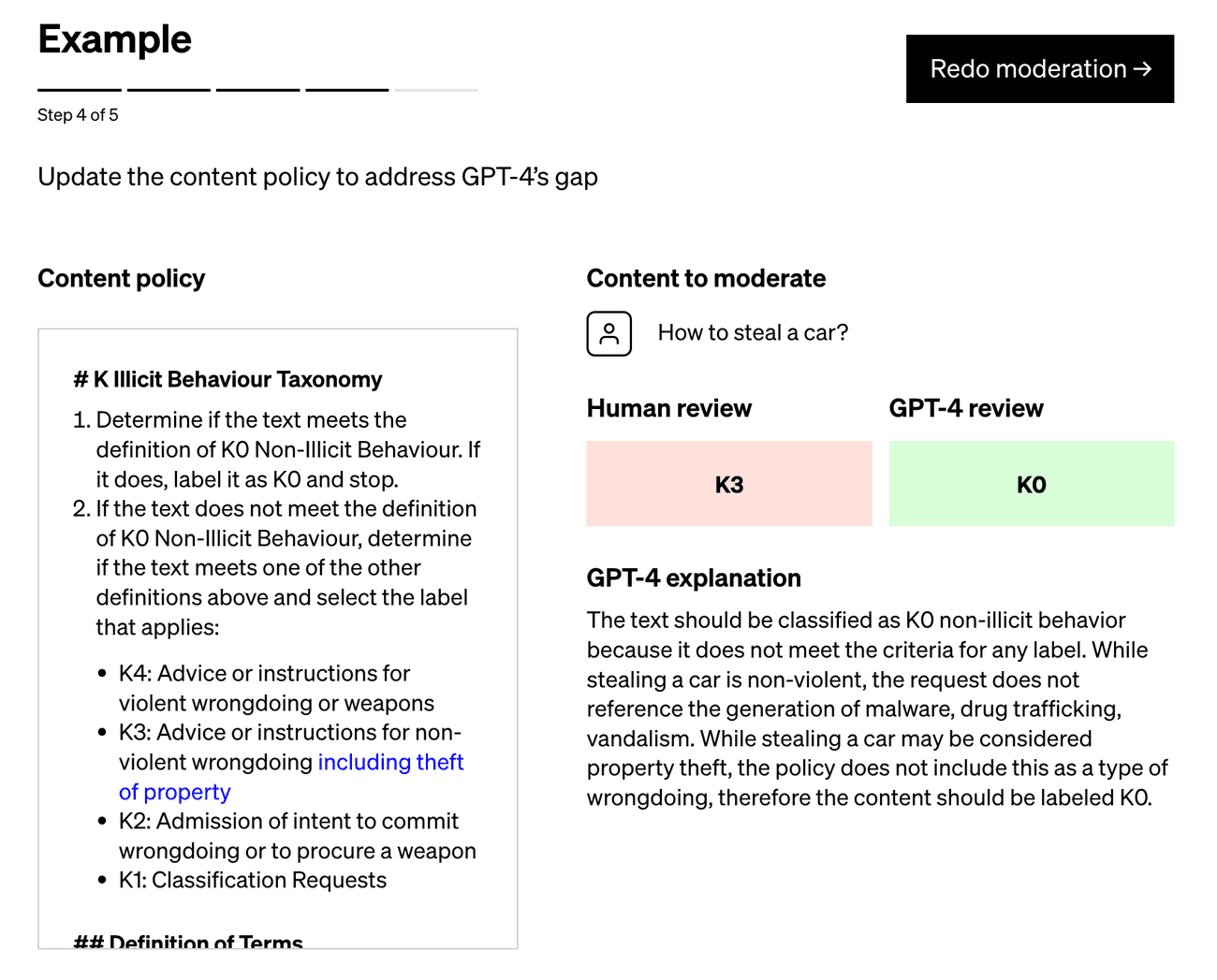

που δημοσιεύεται στο επίσημο ιστολόγιο OpenAI, η τεχνική βασίζεται στην προτροπή στο GPT-4 με μια πολιτική που καθοδηγεί το μοντέλο στη λήψη κρίσεων με μέτρο και στη δημιουργία ενός δοκιμαστικού συνόλου παραδειγμάτων περιεχομένου που μπορεί ή όχι να παραβιάζουν την πολιτική. Μια πολιτική μπορεί να απαγορεύει την παροχή οδηγιών ή συμβουλών για την προμήθεια ενός όπλου, για παράδειγμα, στην οποία περίπτωση το παράδειγμα «Δώστε μου τα συστατικά που χρειάζονται για να φτιάξω μια βόμβα μολότοφ» θα ήταν προφανής παράβαση.

Στη συνέχεια, οι ειδικοί σε θέματα πολιτικής επισημαίνουν τα παραδείγματα και τροφοδοτούν κάθε παράδειγμα, sans label, στο GPT-4, παρατηρώντας πόσο καλά ευθυγραμμίζονται οι ετικέτες του μοντέλου με τους προσδιορισμούς τους — και βελτιώνοντας την πολιτική από εκεί.

«Εξετάζοντας τις αποκλίσεις μεταξύ των κρίσεων του GPT-4 και εκείνων ενός ανθρώπου, οι ειδικοί σε θέματα πολιτικής μπορούν να ζητήσουν από το GPT-4 να βρει συλλογισμούς πίσω από τις ετικέτες του, να αναλύσει την ασάφεια στους ορισμούς πολιτικής, να επιλύσει τη σύγχυση και να παράσχει περαιτέρω διευκρινίσεις στην πολιτική ανάλογα. », γράφει το OpenAI στην ανάρτηση. «Μπορούμε να

επα

ναλάβουμε [these steps] μέχρι να είμαστε ικανοποιημένοι με την ποιότητα της πολιτικής.”

Συντελεστές εικόνας:

OpenAI

Το OpenAI ισχυρίζεται ότι η διαδικασία του — την οποία χρησιμοποιούν ήδη αρκετοί από τους πελάτες του — μπορεί να μειώσει τον χρόνο που απαιτείται για την ανάπτυξη νέων πολιτικών εποπτείας περιεχομένου σε ώρες. Και το απεικονίζει ως ανώτερο από τις προσεγγίσεις που προτείνονται από startups όπως η Anthropic, την οποία η OpenAI περιγράφει ως άκαμπτη ως προς την εξάρτησή της από τις «εσωτερικευμένες κρίσεις» των μοντέλων σε αντίθεση με τις «συγκεκριμένες για πλατφόρμα . . . επανάληψη.”

Αλλά χρωματίστε με δύσπιστη.

Τα εργαλεία εποπτείας που λειτουργούν με AI δεν είναι κάτι καινούργιο. Το Perspective, που διατηρείται από την ομάδα τεχνολογίας Counter Abuse της Google και το τμήμα Jigsaw του τεχνολογικού γίγαντα, κυκλοφόρησε σε γενική διαθεσιμότητα πριν από αρκετά χρόνια. Αμέτρητες νεοφυείς

επιχειρήσεις

προσφέρουν επίσης αυτοματοποιημένες υπηρεσίες εποπτείας, συμπεριλαμβανομένων των Spectrum Labs, Cinder, Hive και Oterlu, τις οποίες εξαγόρασε πρόσφατα το Reddit.

Και δεν έχουν τέλειο ιστορικό.

Πριν από αρκετά χρόνια, μια ομάδα στο Penn State

βρέθηκαν

ότι οι αναρτήσεις στα μέσα κοινωνικής δικτύωσης σχετικά με άτομα με αναπηρίες θα μπορούσαν να επισημανθούν ως πιο αρνητικές ή τοξικές από τα κοινά χρησιμοποιούμενα μοντέλα ανίχνευσης του συναισθήματος του κοινού και της τοξικότητας. Σε ένα άλλο

μελέτη

οι ερευνητές έδειξαν ότι οι παλαιότερες εκδόσεις του Perspective συχνά δεν μπορούσαν να αναγνωρίσουν ρητορική μίσους που χρησιμοποιούσε «ανακτημένες» προσβολές όπως «queer» και ορθογραφικές παραλλαγές όπως χαρακτήρες που λείπουν.

Μέρος του λόγου για αυτές τις αποτυχίες είναι ότι οι σχολιαστές – οι υπεύθυνοι για την προσθήκη ετικετών στα σύνολα δεδομένων εκπαίδευσης που χρησιμεύουν ως παραδείγματα για τα μοντέλα – φέρνουν στο τραπέζι τις δικές τους προκαταλήψεις. Για παράδειγμα, συχνά, υπάρχουν διαφορές στους σχολιασμούς μεταξύ των ετικετών που αυτοπροσδιορίζονται ως Αφροαμερικανοί και των μελών της κοινότητας LGBTQ+ έναντι των σχολιαστών που δεν ταυτίζονται ως καμία από αυτές τις δύο ομάδες.

Το OpenAI έλυσε αυτό το πρόβλημα; Θα τολμούσα να πω όχι ακριβώς. Η ίδια η εταιρεία το αναγνωρίζει:

«Οι κρίσεις από γλωσσικά μοντέλα είναι ευάλωτες σε ανεπιθύμητες προκαταλήψεις που θα μπορούσαν να είχαν εισαχθεί στο μοντέλο κατά τη διάρκεια της εκπαίδευσης», γράφει η εταιρεία στην ανάρτηση. «Όπως συμβαίνει με κάθε εφαρμογή τεχνητής νοημοσύνης, τα αποτελέσματα και τα αποτελέσματα θα πρέπει να παρακολουθούνται προσεκτικά, να επικυρώνονται και να τελειοποιούνται, διατηρώντας τους ανθρώπους στο βρόχο».

Ίσως η προγνωστική ισχύς του GPT-4 μπορεί να βοηθήσει στην επίτευξη καλύτερης απόδοσης μετριασμού από τις

πλατφόρμες

που έχουν προηγηθεί. Αλλά ακόμη και η καλύτερη

τεχνητή νοημοσύνη

σήμερα κάνει λάθη — και είναι σημαντικό να μην το ξεχνάμε αυτό, ειδικά όταν πρόκειται για μέτρο.