Γιατί οι εταιρείες τεχνολογίας συνεχίζουν να κάνουν ρατσιστικά λάθη με την τεχνητή νοημοσύνη

Related Posts

:

Πηγή: John MacCormick, CC BY-ND

Το 1998, δημιούργησα άθελά μου έναν αλγόριθμο τεχνητής νοημοσύνης με φυλετική προκατάληψη. Υπάρχουν μαθήματα σε αυτή την ιστορία που αντηχούν ακόμη πιο έντονα σήμερα.

Οι κίνδυνοι του

μεροληψία και σφάλματα σε αλγόριθμους τεχνητής νοημοσύνης

είναι πλέον γνωστά. Γιατί, λοιπόν, σημειώθηκε σωρεία γκάφες από εταιρείες τεχνολογίας τους τελευταίους μήνες, ειδικά στον κόσμο των chatbots AI και των παραγωγών εικόνων; Παρήχθησαν οι αρχικές εκδόσεις του ChatGPT

ρατσιστική παραγωγή

. Έδειξαν και οι δύο γεννήτριες εικόνας DALL-E 2 και Stable Diffusion

φυλετική προκατάληψη

στις εικόνες που δημιούργησαν.

Η δική μου επιφοίτηση ως λευκό αρσενικό

επιστήμονας υπολογιστών

συνέβη κατά τη διδασκαλία ενός μαθήματος επιστήμης υπολογιστών το 2021. Η τάξη μόλις είχε δει ένα ποίημα βίντεο της Joy Buolamwini,

Ερευνητής και καλλιτέχνης AI

και η αυτοπεριγραφόμενη

ποιητής του κώδικα

. Το βίντεο ποίημά της για το 2019 “

AI, δεν είμαι γυναίκα;

” είναι μια καταστροφική έκθεση τριών λεπτών φυλετικών και φυλετικών προκαταλήψεων σε συστήματα αυτόματης αναγνώρισης προσώπου – συστήματα που αναπτύχθηκαν από εταιρείες τεχνολογίας όπως η Google και η Microsoft.

Τα συστήματα συχνά αποτυγχάνουν στις έγχρωμες γυναίκες, χαρακτηρίζοντάς τις εσφαλμένα ως αρσενικές. Μερικές από τις αποτυχίες είναι ιδιαίτερα τρομερές: Τα μαλλιά της ηγέτιδας των πολιτικών δικαιωμάτων των Μαύρων, Ida B. Wells χαρακτηρίζονται ως «σκουφάκι από κοτσάνι». Μια άλλη μαύρη γυναίκα χαρακτηρίζεται ότι έχει «μουστάκι θαλάσσιου θαλάσσιου ίππου».

Αντηχώντας μέσα στα χρόνια

Είχα μια φρικτή στιγμή déjà vu σε εκείνο το μάθημα επιστήμης υπολογιστών: Ξαφνικά θυμήθηκα ότι κι εγώ είχα δημιουργήσει κάποτε έναν αλγόριθμο με φυλετική προκατάληψη. Το 1998 ήμουν διδακτορικός φοιτητής. Το έργο μου περιελάμβανε την παρακολούθηση των κινήσεων του κεφαλιού ενός ατόμου με βάση τα δεδομένα από μια βιντεοκάμερα. Ο διδακτορικός μου σύμβουλος είχε ήδη αναπτυχθεί

μαθηματικές τεχνικές

για να ακολουθείτε με ακρίβεια το κεφάλι σε ορισμένες περιπτώσεις, αλλά το σύστημα έπρεπε να είναι πολύ πιο γρήγορο και πιο στιβαρό. Νωρίτερα στη δεκαετία του 1990,

ερευνητές σε άλλα εργαστήρια

είχε δείξει ότι οι χρωματιστές περιοχές μιας εικόνας μπορούσαν να εξαχθούν σε πραγματικό χρόνο. Αποφασίσαμε λοιπόν να εστιάσουμε στο χρώμα του δέρματος ως πρόσθετο σημάδι για τον ιχνηλάτη.

Χρησιμοποίησα μια ψηφιακή φωτογραφική μηχανή –σπάνια ακόμα εκείνη την εποχή– για να τραβήξω μερικές λήψεις από το χέρι και το πρόσωπό μου, και επίσης έσπασα τα χέρια και τα πρόσωπα δύο ή τριών άλλων ατόμων που έτυχε να βρίσκονταν στο κτίριο. Ήταν εύκολο να εξαχθούν χειροκίνητα μερικά από τα χρωματιστά pixel από αυτές τις εικόνες και να κατασκευαστεί ένα στατιστικό μοντέλο για τα χρώματα του δέρματος. Μετά από κάποιες τροποποιήσεις και διόρθωση σφαλμάτων, είχαμε έναν εκπληκτικά ισχυρό πραγματικό χρόνο

σύστημα ανίχνευσης κεφαλής

.

Λίγο αργότερα, ο σύμβουλός μου μου ζήτησε να δείξω το σύστημα σε ορισμένα στελέχη της εταιρείας που επισκέπτονταν. Όταν μπήκαν στο δωμάτιο, πλημμύρισα αμέσως από άγχος: τα στελέχη ήταν Ιάπωνες. Στο περιστασιακό μου πείραμα για να δω αν ένα απλό στατιστικό μοντέλο θα λειτουργούσε με το πρωτότυπό μας, είχα συλλέξει δεδομένα από τον εαυτό μου και από μια χούφτα άλλων που έτυχε να βρεθούν στο κτίριο. Αλλά το 100% αυτών των ατόμων είχαν «λευκό» δέρμα. τα ιαπωνικά στελέχη δεν το έκαναν.

Ως εκ θαύματος, το σύστημα λειτούργησε αρκετά καλά στα στελέχη ούτως ή άλλως. Αλλά σοκαρίστηκα από τη συνειδητοποίηση ότι είχα δημιουργήσει ένα φυλετικά προκατειλημμένο σύστημα που θα μπορούσε εύκολα να αποτύχει για άλλους μη λευκούς ανθρώπους.

Προνόμια και προτεραιότητες

Πώς και γιατί καλομαθημένοι, καλοπροαίρετοι επιστήμονες παράγουν προκατειλημμένα συστήματα τεχνητής νοημοσύνης; Οι κοινωνιολογικές θεωρίες των προνομίων παρέχουν έναν χρήσιμο φακό.

Δέκα χρόνια πριν δημιουργήσω το σύστημα παρακολούθησης κεφαλής, η μελετήτρια Peggy McIntosh πρότεινε την ιδέα ενός «

αόρατο σακίδιο

” που μεταφέρονται από λευκούς ανθρώπους. Μέσα στο σακίδιο υπάρχει ένας θησαυρός προνομίων όπως «Μπορώ να τα πάω καλά σε μια δύσκολη κατάσταση χωρίς να με αποκαλούν εύσημα για τη φυλή μου» και «Μπορώ να επικρίνω την κυβέρνησή μας και να μιλάω για το πόσο φοβάμαι τις πολιτικές και τη συμπεριφορά της χωρίς να είμαι θεωρείται ως πολιτιστικό αουτσάιντερ».

Στην εποχή της τεχνητής νοημοσύνης, αυτό το σακίδιο χρειάζεται κάποια νέα αντικείμενα, όπως «τα συστήματα AI δεν θα δίνουν κακά αποτελέσματα λόγω της φυλής μου». Το αόρατο σακίδιο ενός λευκού επιστήμονα θα χρειαζόταν επίσης: «Μπορώ να αναπτύξω ένα σύστημα AI με βάση τη δική μου εμφάνιση και να ξέρω ότι θα λειτουργήσει καλά για τους περισσότερους από τους χρήστες μου».

Το βίντεο ποίημα της ερευνήτριας και καλλιτέχνη AI Joy Buolamwini “AI, Ain’t I a Woman?”

Μια προτεινόμενη θεραπεία για το προνόμιο λευκού είναι να είστε ενεργοί

αντιρατσιστικός

. Για το σύστημα παρακολούθησης κεφαλής του 1998, μπορεί να φαίνεται προφανές ότι η αντιρατσιστική θεραπεία είναι να αντιμετωπίζονται όλα τα χρώματα του δέρματος εξίσου. Ασφαλώς, μπορούμε και πρέπει να διασφαλίσουμε ότι τα δεδομένα εκπαίδευσης του συστήματος αντιπροσωπεύουν το εύρος όλων των χρωμάτων δέρματος όσο το δυνατόν εξίσου.

Δυστυχώς, αυτό δεν εγγυάται ότι όλα τα χρώματα δέρματος που παρατηρούνται από το σύστημα θα αντιμετωπίζονται ισότιμα. Το σύστημα πρέπει να ταξινομεί κάθε πιθανό χρώμα ως δέρμα ή μη δέρμα. Επομένως, υπάρχουν χρώματα ακριβώς στο όριο μεταξύ του δέρματος και του μη δέρματος – μια περιοχή που οι επιστήμονες υπολογιστών αποκαλούν το όριο απόφασης. Ένα άτομο του οποίου το χρώμα δέρματος υπερβαίνει αυτό το όριο απόφασης θα ταξινομηθεί εσφαλμένα.

Οι επιστήμονες αντιμετωπίζουν επίσης ένα δυσάρεστο υποσυνείδητο δίλημμα όταν ενσωματώνουν τη διαφορετικότητα στα μοντέλα μηχανικής μάθησης: Τα διαφορετικά μοντέλα χωρίς αποκλεισμούς έχουν χειρότερη απόδοση από τα στενά μοντέλα.

Μια απλή αναλογία μπορεί να το εξηγήσει αυτό. Φανταστείτε ότι σας δίνεται η επιλογή ανάμεσα σε δύο εργασίες. Η εργασία Α είναι να προσδιορίσετε έναν συγκεκριμένο τύπο δέντρου – ας πούμε, τις φτελιές. Η εργασία Β είναι να αναγνωρίσετε πέντε είδη δέντρων: φτελιά, στάχτη, ακρίδα, οξιά και καρυδιά. Είναι προφανές ότι αν σας δοθεί σταθερός χρόνος για εξάσκηση, θα αποδώσετε καλύτερα στο Task A από το Task B.

Με τον ίδιο τρόπο, ένας αλγόριθμος που παρακολουθεί μόνο το λευκό δέρμα θα είναι πιο ακριβής από έναν αλγόριθμο που παρακολουθεί όλο το φάσμα των χρωμάτων του ανθρώπινου δέρματος. Ακόμα κι αν έχουν επίγνωση της ανάγκης για διαφορετικότητα και δικαιοσύνη, οι επιστήμονες μπορεί υποσυνείδητα να επηρεαστούν από αυτήν την ανταγωνιστική ανάγκη για ακρίβεια.

Κρυμμένο στους αριθμούς

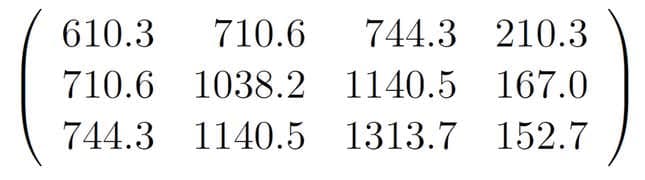

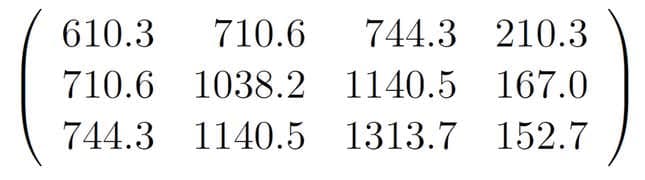

Η δημιουργία ενός μεροληπτικού αλγορίθμου ήταν αλόγιστη και δυνητικά προσβλητική. Ακόμη πιο ανησυχητικό, αυτό το περιστατικό δείχνει πώς η προκατάληψη μπορεί να παραμείνει κρυμμένη βαθιά μέσα σε ένα σύστημα AI. Για να δείτε γιατί, εξετάστε ένα συγκεκριμένο σύνολο 12 αριθμών σε έναν πίνακα τριών σειρών και τεσσάρων στηλών. Φαίνονται ρατσιστές; Ο αλγόριθμος παρακολούθησης κεφαλής που ανέπτυξα το 1998 ελέγχεται από μια μήτρα όπως αυτή, η οποία περιγράφει το μοντέλο χρώματος δέρματος. Αλλά είναι αδύνατο να πούμε μόνο από αυτούς τους αριθμούς ότι πρόκειται στην πραγματικότητα για μια ρατσιστική μήτρα. Είναι απλώς αριθμοί, που καθορίζονται αυτόματα από ένα πρόγραμμα υπολογιστή.

:

John MacCormick, CC BY-ND

Το πρόβλημα της μεροληψίας απόκρυψης σε κοινή θέα είναι πολύ πιο σοβαρό στα σύγχρονα συστήματα μηχανικής μάθησης. Τα βαθιά νευρωνικά δίκτυα – επί του παρόντος ο πιο δημοφιλής και ισχυρός τύπος μοντέλου τεχνητής νοημοσύνης – έχουν συχνά εκατομμύρια αριθμούς στους οποίους θα μπορούσαν να κωδικοποιηθούν μεροληψία. Τα προκατειλημμένα συστήματα αναγνώρισης προσώπου που επικρίθηκαν στο “AI, Ain’t I a Woman?” είναι όλα βαθιά νευρωνικά δίκτυα.

Τα καλά νέα είναι ότι έχει ήδη σημειωθεί μεγάλη πρόοδος στη δικαιοσύνη της τεχνητής νοημοσύνης, τόσο στον ακαδημαϊκό χώρο όσο και στη βιομηχανία. Η Microsoft, για παράδειγμα, έχει μια ερευνητική ομάδα γνωστή ως

ΜΟΙΡΑ

, αφιερωμένο στη δικαιοσύνη, την υπευθυνότητα, τη διαφάνεια και την ηθική στην τεχνητή νοημοσύνη. Ένα κορυφαίο συνέδριο μηχανικής μάθησης, το NeurIPS, αναφέρει λεπτομερώς

κατευθυντήριες γραμμές δεοντολογίας

συμπεριλαμβανομένης μιας λίστας οκτώ σημείων αρνητικών κοινωνικών επιπτώσεων που πρέπει να ληφθούν υπόψη από ερευνητές που υποβάλλουν εργασίες.

Αυτός που είναι στο δωμάτιο είναι αυτός που βρίσκεται στο τραπέζι

Από την άλλη πλευρά, ακόμη και το 2023, η δικαιοσύνη μπορεί ακόμα να είναι θύμα ανταγωνιστικών πιέσεων στον ακαδημαϊκό χώρο και τη βιομηχανία. Το ελαττωματικό

Bard και Bing chatbots

από την Google και τη Microsoft είναι πρόσφατες αποδείξεις αυτής της ζοφερής πραγματικότητας. Η εμπορική αναγκαιότητα δημιουργίας μεριδίου αγοράς οδήγησε στην πρόωρη κυκλοφορία αυτών των συστημάτων.

Τα συστήματα αντιμετωπίζουν ακριβώς τα ίδια προβλήματα με το head tracker του 1998. Τα δεδομένα εκπαίδευσής τους είναι μεροληπτικά. Σχεδιάζονται από μια μη αντιπροσωπευτική ομάδα. Αντιμετωπίζουν τη μαθηματική αδυναμία να αντιμετωπίζουν όλες τις κατηγορίες ισότιμα. Πρέπει με κάποιο τρόπο να ανταλλάξουν την ακρίβεια με τη δικαιοσύνη. Και οι προκαταλήψεις τους κρύβονται πίσω από εκατομμύρια ανεξιχνίαστες αριθμητικές παραμέτρους.

Λοιπόν, πόσο μακριά έχει φτάσει πραγματικά το πεδίο της τεχνητής νοημοσύνης από τότε που ήταν δυνατό, πριν από περισσότερα από 25 χρόνια, ένας διδακτορικός φοιτητής να σχεδιάσει και να δημοσιεύσει τα αποτελέσματα ενός φυλετικά προκατειλημμένου αλγορίθμου χωρίς προφανή παράβλεψη ή συνέπειες; Είναι σαφές ότι τα προκατειλημμένα συστήματα AI μπορούν ακόμα να δημιουργηθούν ακούσια και εύκολα. Είναι επίσης σαφές ότι η μεροληψία σε αυτά τα συστήματα μπορεί να είναι επιβλαβής, δύσκολο να εντοπιστεί και ακόμη πιο δύσκολο να εξαλειφθεί.

Αυτές τις μέρες είναι κλισέ να πούμε ότι η βιομηχανία και ο ακαδημαϊκός κόσμος χρειάζονται διαφορετικές ομάδες ανθρώπων «στο δωμάτιο» που σχεδιάζουν αυτούς τους αλγόριθμους. Θα ήταν χρήσιμο αν το γήπεδο μπορούσε να φτάσει σε αυτό το σημείο. Αλλά στην πραγματικότητα, με τα διδακτορικά προγράμματα επιστήμης υπολογιστών της Βόρειας Αμερικής να αποφοιτούν μόνο περίπου

23% γυναίκες και 3% Μαύροι και Λατίνοι φοιτητές

θα συνεχίσουν να υπάρχουν πολλά δωμάτια και πολλοί αλγόριθμοι στους οποίους δεν αντιπροσωπεύονται καθόλου υποεκπροσωπούμενες ομάδες.

Γι’ αυτό τα θεμελιώδη μαθήματα του head tracker του 1998 είναι ακόμη πιο σημαντικά σήμερα: Είναι εύκολο να κάνεις ένα λάθος, είναι εύκολο να εισέλθει η μεροληψία χωρίς να εντοπιστεί και όλοι στην αίθουσα είναι υπεύθυνοι για την αποτροπή του.

Θέλετε να μάθετε περισσότερα για την τεχνητή νοημοσύνη, τα chatbots και το μέλλον της μηχανικής μάθησης; Δείτε την πλήρη κάλυψή μας για

τεχνητή νοημοσύνη

ή περιηγηθείτε στους οδηγούς μας

Οι καλύτερες δωρεάν γεννήτριες τέχνης AI

και

Όλα όσα γνωρίζουμε για το ChatGPT του OpenAI

.

Τζον ΜακΚόρμικ

Καθηγητής Πληροφορικής,

Κολέγιο Dickinson

Αυτό το άρθρο αναδημοσιεύεται από

Η συζήτηση

με άδεια Creative Commons. Διαβάστε το

πρωτότυπο άρθρο

.