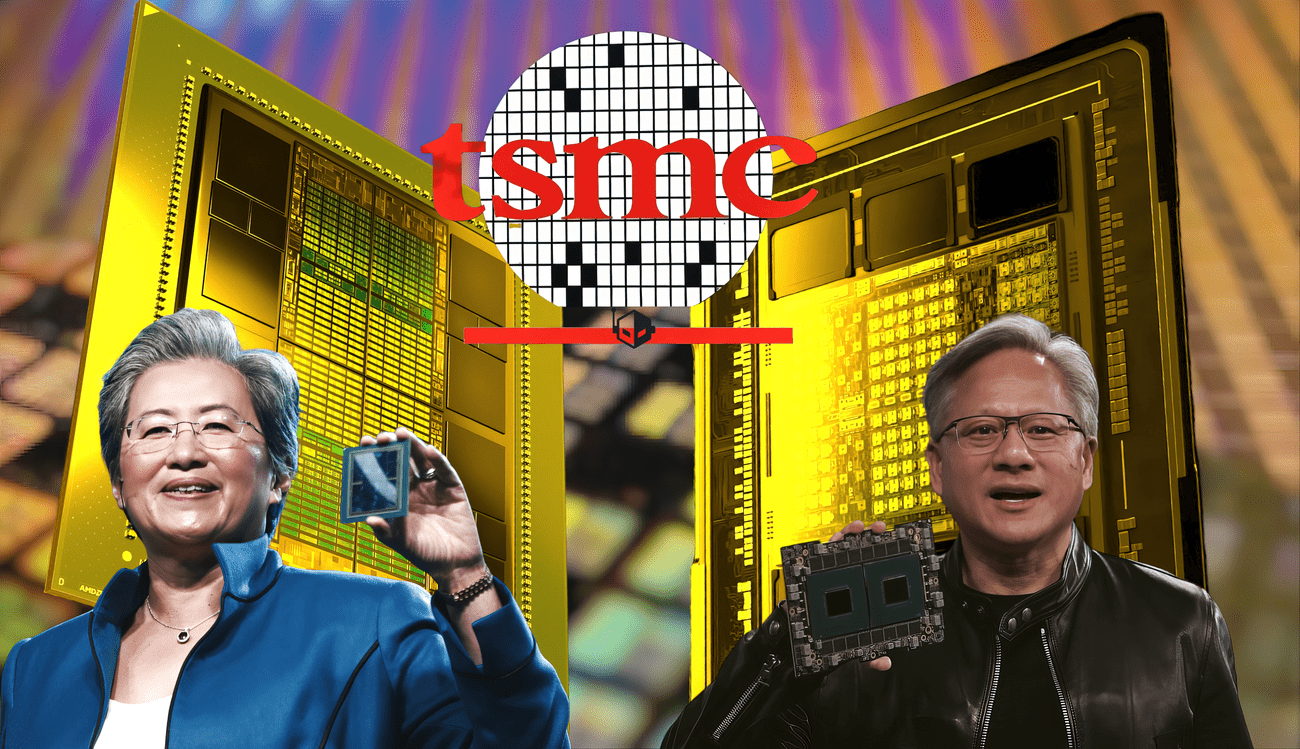

Η AMD ανταποκρίνεται στα αποτελέσματα H100 TensorRT-LLM της NVIDIA, για άλλη μια φορά δείχνει ότι η GPU MI300X είναι κορυφαία με 30% καλύτερη απόδοση χρησιμοποιώντας βελτιστοποιημένη στοίβα λογισμικού AI

Η AMD έχει

αποκρίθηκε

στο

H100

TensorRT-LLM της NVIDIA με το

MI300X

να πρωτοπορεί για άλλη μια φορά στα σημεία αναφοράς AI κατά την εκτέλεση βελτιστοποιημένου λογισμικού.

Πριν από δύο ημέρες, η NVIDIA δημοσίευσε νέα σημεία αναφοράς για τις GPU Hopper H100 για να δείξει ότι τα τσιπ της αποδίδουν πολύ καλύτερα από αυτό που παρουσίασε η AMD κατά τη διάρκεια της εκδήλωσης “Advancing AI”. Η κόκκινη ομάδα συνέκρινε την ολοκαίνουργια GPU

Instinct

MI300X με το τσιπ Hopper H100, το οποίο είναι πάνω από ένα χρόνο ζωής τώρα, αλλά παραμένει η πιο δημοφιλής επιλογή στον κλάδο της τεχνητής νοημοσύνης. Τα σημεία αναφοράς που χρησιμοποίησε η AMD δεν χρησιμοποιούσαν τις βελτιστοποιημένες βιβλιοθήκες όπως το TensorRT-LLM, το οποίο παρέχει μεγάλη ώθηση στα τσιπ AI της NVIDIA.

Η χρήση του TensorRT-LLM είχε ως αποτέλεσμα η GPU Hopper H100 να αποκτά σχεδόν 50% αύξηση απόδοσης σε σχέση με την GPU Instinct MI300X της AMD. Τώρα, η AMD ενεργοποιείται με όλους τους κυλίνδρους πίσω στη NVIDIA, δείχνοντας πώς το MI300X εξακολουθεί να διατηρεί ταχύτερη απόδοση από το H100, ακόμη και όταν το Hopper H100 εκτελεί τη βελτιστοποιημένη στοίβα λογισμικού του. Σύμφωνα με την AMD, οι αριθμοί που δημοσίευσε η NVIDIA:

- Χρησιμοποιήθηκε το TensorRT-LLM στο H100 αντί για το vLLM που χρησιμοποιείται στα σημεία αναφοράς AMD

- Σύγκριση απόδοσης τύπου δεδομένων FP16 σε GPU AMD Instinct MI300X με τύπο δεδομένων FP8 σε H100

- Ανέστρεψε τα δημοσιευμένα από την AMD δεδομένα απόδοσης από αριθμούς σχετικής καθυστέρησης στην απόλυτη απόδοση

Έτσι, η AMD αποφάσισε να προχωρήσει σε μια πιο δίκαιη σύγκριση και με τα τελευταία στοιχεία, βλέπουμε το Instinct MI300X να λειτουργεί σε vLLM να προσφέρει 30% ταχύτερη απόδοση από το Hopper H100 που τρέχει σε TensorRT-LLM.

- MI300X σε H100 χρησιμοποιώντας vLLM και για τα δύο.

- Στην εκδήλωση παρουσίασης στις αρχές Δεκεμβρίου, επισημάναμε ένα πλεονέκτημα απόδοσης 1,4x για το MI300X έναντι του H100 χρησιμοποιώντας αντίστοιχο τύπο δεδομένων και ρύθμιση βιβλιοθήκης. Με τις τελευταίες βελτιστοποιήσεις που έχουμε κάνει, αυτό το πλεονέκτημα απόδοσης έχει αυξηθεί σε 2,1x.

- Επιλέξαμε το vLLM με βάση την ευρεία υιοθέτηση από την κοινότητα χρηστών και προγραμματιστών και υποστηρίζει και τις δύο GPU της AMD και της Nvidia.

- MI300X χρησιμοποιώντας vLLM έναντι H100 χρησιμοποιώντας το βελτιστοποιημένο TensorRT-LLM της Nvidia

- Ακόμη και όταν χρησιμοποιούμε το TensorRT-LLM για το H100 όπως υπογράμμισε ο ανταγωνιστής μας και το vLLM για το MI300X, εξακολουθούμε να παρουσιάζουμε βελτίωση 1,3 φορές στον λανθάνοντα χρόνο.

- Μετρήθηκαν τα αποτελέσματα λανθάνουσας κατάστασης για το σύνολο δεδομένων MI300X FP16 έναντι του H100 με χρήση δεδομένων TensorRT-LLM και FP8.

- Το MI300X συνεχίζει να επιδεικνύει πλεονέκτημα απόδοσης κατά τη μέτρηση του απόλυτου λανθάνοντος χρόνου, ακόμη και όταν χρησιμοποιεί χαμηλότερης ακρίβειας FP8 και TensorRT-LLM για H100 έναντι vLLM και τον τύπο δεδομένων FP16 υψηλότερης ακρίβειας για MI300X.

- Χρησιμοποιούμε τον τύπο δεδομένων FP16 λόγω της δημοτικότητάς του και σήμερα, το vLLM δεν υποστηρίζει το FP8.

Αυτά τα αποτελέσματα δείχνουν και πάλι ότι το MI300X που χρησιμοποιεί το FP16 είναι συγκρίσιμο με το H100 με τις καλύτερες ρυθμίσεις απόδοσης που προτείνει η Nvidia ακόμη και όταν χρησιμοποιεί FP8 και TensorRT-LLM.

Σίγουρα, αυτοί οι αριθμοί μεταξύ τους είναι κάτι που είναι κάπως απροσδόκητο, αλλά δεδομένου του πόσο σημαντική έχει γίνει η τεχνητή νοημοσύνη για εταιρείες όπως η AMD, η NVIDIA και η Intel, μπορούμε να περιμένουμε να δούμε περισσότερα τέτοια παραδείγματα να μοιράζονται στο μέλλον. Ακόμη και η Intel δήλωσε πρόσφατα ότι ολόκληρη η βιομηχανία έχει κίνητρο να τερματίσει την κυριαρχία της NVIDIA CUDA στον κλάδο. Το γεγονός προς το παρόν είναι ότι η NVIDIA έχει χρόνια εμπειρίας λογισμικού στον τομέα της τεχνητής νοημοσύνης και ενώ το Instinct MI300X προσφέρει κάποιες θηριώδεις προδιαγραφές, σύντομα θα ανταγωνιστεί μια ακόμη πιο γρήγορη λύση Hopper με τη μορφή H200 και τις επερχόμενες GPU Blackwell B100 στο

2024

.

Η Intel είναι επίσης έτοιμη να κυκλοφορήσει τους επιταχυντές Gaudi 3 το 2024, οι οποίοι θα θερμάνουν περαιτέρω τον χώρο της τεχνητής νοημοσύνης, αλλά κατά κάποιο τρόπο, αυτός ο

ανταγωνισμός

θα δημιουργήσει μια ζωντανή και πιο ζωντανή βιομηχανία τεχνητής νοημοσύνης όπου κάθε προμηθευτής συνεχίζει να καινοτομεί και να υπερέχει έναντι του άλλου, προσφέροντας στους πελάτες καλύτερες δυνατότητες και ακόμη πιο γρήγορη απόδοση. Η NVIDIA, παρά το γεγονός ότι δεν έχει ανταγωνισμό εδώ και χρόνια, συνέχισε να καινοτομεί σε αυτό το τμήμα και με την AMD και την Intel να αυξάνουν την παραγωγή και το λογισμικό τεχνητής νοημοσύνης τους, μπορούμε να περιμένουμε ότι θα ανταποκριθούν με ακόμα καλύτερο δικό τους υλικό/λογισμικό.

VIA:

wccftech.com