Η ομάδα OpenAI του Ilya Sutskever κατασκεύασε εργαλεία για τον έλεγχο του Υπερανθρώπινου AI

Μια νέα ερευνητική εργασία από το OpenAI την Πέμπτη λέει ότι μια υπεράνθρωπη

τεχνητή νοημοσύνη

έρχεται και η εταιρεία

αναπτύσσει

εργαλεία για να διασφαλίσει ότι δεν στρέφεται εναντίον των ανθρώπων. Ο επικεφαλής επιστήμονας του OpenAI, Ilya Sutskever αναφέρεται ως κύριος συγγραφέας στο

χαρτί

αλλά όχι το

ανάρτηση

αυτό συνέβη και ο ρόλος του στην εταιρεία παραμένει ασαφής.

«Πιστεύουμε ότι η υπερευφυΐα – AI πολύ πιο έξυπνη από τους ανθρώπους – θα μπορούσε να αναπτυχθεί μέσα στα επόμενα δέκα χρόνια», δήλωσε το OpenAI σε

ανάρτηση

. «Το να βρούμε πώς να ευθυγραμμίσουμε τα μελλοντικά συστήματα υπερανθρώπινων τεχνητής νοημοσύνης ώστε να είναι ασφαλή δεν ήταν ποτέ πιο σημαντικό και τώρα είναι ευκολότερο από ποτέ να σημειωθεί εμπειρική πρόοδος σε αυτό το

πρόβλημα

».

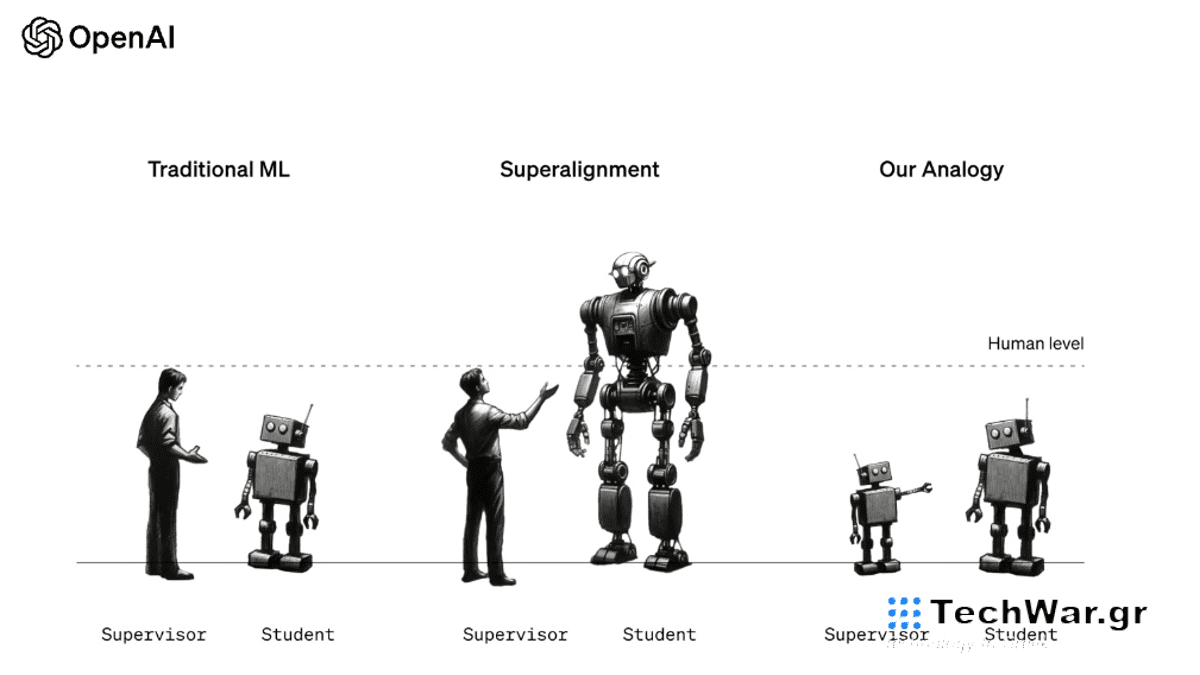

Η «γενίκευση από αδύναμη προς ισχυρή» είναι η πρώτη εργασία από την ομάδα «Superalignment» των Ilya Sutskever και Jan Leike,

δημιουργήθηκε τον Ιούλιο

για να βεβαιωθείτε ότι τα συστήματα AI πολύ πιο έξυπνα από τους ανθρώπους θα εξακολουθούν να ακολουθούν τους ανθρώπινους κανόνες. Η προτεινόμενη λύση; Το OpenAI πρέπει να σχεδιάσει μικρά μοντέλα τεχνητής νοημοσύνης για να διδάξει υπεράνθρωπα μοντέλα τεχνητής νοημοσύνης.

Επί του παρόντος, το OpenAI χρησιμοποιεί ανθρώπους για να «ευθυγραμμίσει» το ChatGPT παρέχοντάς του καλά σχόλια ή αρνητικά σχόλια. Αυτός είναι ο τρόπος με τον οποίο το OpenAI διασφαλίζει ότι το ChatGPT δεν θα δώσει στους ανθρώπους οδηγίες για το πώς να φτιάχνουν ναπάλμ στο σπίτι ή άλλα επικίνδυνα αποτελέσματα. Καθώς το ChatGPT γίνεται πιο έξυπνο, ωστόσο, το OpenAI αναγνωρίζει ότι οι άνθρωποι δεν θα

επα

ρκούν για να εκπαιδεύσουν αυτά τα μοντέλα, επομένως πρέπει να εκπαιδεύσουμε ένα λιγότερο περίπλοκο AI για να το κάνει για λογαριασμό μας.

Αυτό είναι το πρώτο σημάδι ζωής από τον Ilya Sutskever στο OpenAI από τότε που ο Sam Altman ανακοίνωσε ότι σχεδόν όλοι επέστρεψαν στο OpenAI ενώ άφησε το status του Sutskever

Ψηλά στον αέρα

. Ο Sutskever, συνιδρυτής του OpenAI, ήταν ένα από τα μέλη του διοικητικού συμβουλίου πίσω

Ο Άλτμαν απολύεται

, και είναι ηγετική φωνή στην κοινότητα AI για την υπεύθυνη ανάπτυξη AI. Δεν οδηγεί πλέον την εταιρεία προς τα εμπρός, αλλά μπορεί ακόμα να έχει έναν ρόλο εκεί.

Ο άλλος αρχηγός της ομάδας Superalignment του OpenAI, Leike,

έδωσε συγχαρητήρια στον Ilya

για το «άναψε τις φωτιές» την Πέμπτη, αλλά επαίνεσε άλλους που «προχωρούν τα πράγματα κάθε μέρα». Τα σχόλια εγείρουν ένα ερώτημα εάν ο Sutskever ξεκίνησε αυτό το έργο, αλλά δεν ήταν κοντά για να το ολοκληρώσει.

Σύμφωνα με πληροφορίες, ήταν αόρατος στην εταιρεία τις τελευταίες εβδομάδες και έχει προσλάβει δικηγόρο, είπαν πηγές

Business Insider

. Ο Jan Leike και άλλα μέλη της ομάδας Superalignment του OpenAI έκαναν δημόσιες δηλώσεις σε αυτό το έγγραφο ορόσημο, αλλά ο Sutskever δεν έχει πει λέξη – απλώς κάνει retweet.

Η μελέτη διαπίστωσε ότι η εκπαίδευση μεγάλων μοντέλων τεχνητής νοημοσύνης με μικρότερα μοντέλα τεχνητής νοημοσύνης, αυτό που αποκαλούν «γενίκευση από αδύναμη προς ισχυρή» έχει ως αποτέλεσμα υψηλότερο επίπεδο ακρίβειας σε πολλαπλές περισ

τάσεις

, σε σύγκριση με την ανθρώπινη εκπαίδευση. Μεγάλο μέρος της μελέτης χρησιμοποίησε το GPT-2 για την εκπαίδευση του GPT-4. Είναι σημαντικό να σημειωθεί ότι το OpenAI λέει ότι δεν είναι πεπεισμένο ότι αυτή είναι μια «λύση» για την υπερευθυγράμμιση, αυτό είναι απλώς ένα πολλά υποσχόμενο πλαίσιο για την εκπαίδευση ενός υπερανθρώπινου AI.

«Τα υπερανθρώπινα μοντέλα σε γενικές γραμμές θα ήταν εξαιρετικά ισχυρά και, εάν χρησιμοποιηθούν κακώς ή δεν ευθυγραμμιστούν με τις ανθρώπινες αξίες, θα μπορούσαν ενδεχομένως να προκαλέσουν καταστροφική βλάβη», είπαν οι ερευνητές του OpenAI στη μελέτη, σημειώνοντας ότι δεν είναι σαφές πώς να μελετηθεί εμπειρικά αυτό το θέμα. «Πιστεύουμε ότι είναι πλέον ευκολότερο να σημειωθεί πρόοδος σε αυτό το πρόβλημα από ποτέ».

Υπήρχε σημαντική εικασία ότι

Το OpenAI ήταν κοντά στο AGI

τον Νοέμβριο, αν και πολλά από αυτά ήταν ασαφή. Αυτό το έγγραφο επιβεβαιώνει ότι το OpenAI δημιουργεί ενεργά εργαλεία για τον έλεγχο ενός AGI, αλλά δεν επιβεβαιώνει την ύπαρξη ενός AGI. Όσο για τον Ilya Sutskever, η κατάστασή του παραμένει σε ένα περίεργο κενό. Το OpenAI δεν έχει επιβεβαιώσει τη θέση του στην εταιρεία, αλλά η ομάδα του απλώς έκανε αθόρυβα πρωτοποριακή έρευνα καθώς κάνει retweet τις εταιρικές τους ανακοινώσεις.

VIA:

gizmodo.com