Απίστευτη ανακάλυψη! Μια βαθιά κατάδυση στο Mixtral 8x7B αποκαλύπτει μυστηριώδες μυστικό!

Γνωρίστε το

Mixtral 8x7B

by Mistral AI. Είναι εξαιρετικά έξυπνο στην αντιμετώπιση μεγάλων δεδομένων και μπορεί να βοηθήσει σε εργασίες όπως η μετάφραση γλωσσών και η δημιουργία κώδικα. Οι

προγραμματιστές

σε όλο τον κόσμο είναι ενθουσιασμένοι με τις δυνατότητές του να εξορθολογίσουν τα έργα τους και να βελτιώσουν την αποτελεσματικότητα. Με τον φιλικό προς τον χρήστη σχεδιασμό και τις εντυπωσιακές δυνατότητές του, το Mixtral 8x7B γίνεται γρήγορα ένα βασικό εργαλείο για την ανάπτυξη AI.

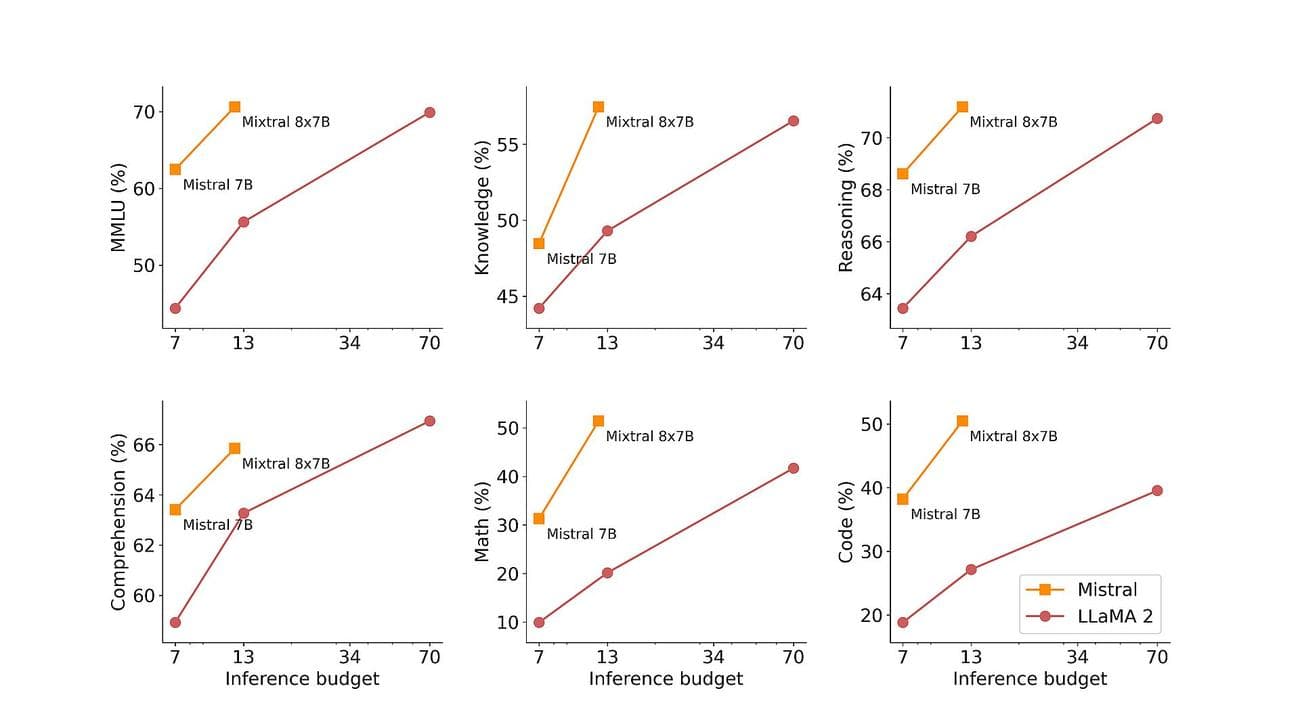

Επίσης, υπάρχει ένα ενδιαφέρον γεγονός σχετικά με αυτό: Έχει καλύτερη απόδοση από το GPT-3.5 και το Llama 2!

Πίστωση εικόνας

)

Τι είναι το Mixtral 8x7B;

Το Mixtral 8x7B είναι ένα προηγμένο μοντέλο τεχνητής νοημοσύνης που αναπτύχθηκε από τη Mistral AI. Χρησιμοποιεί μια μοναδική αρχιτεκτονική που ονομάζεται sparse mix-of-

experts

(SMoE) για την αποτελεσματική επεξεργασία μεγάλων ποσοτήτων δεδομένων. Παρά την πολυπλοκότητά του, το Mixtral έχει σχεδιαστεί για να είναι εύκολο στη χρήση και προσαρμόσιμο για διάφορες εργασίες όπως η μετάφραση γλώσσας και η δημιουργία κώδικα. Ξεπερνά τα άλλα μοντέλα όσον αφορά την ταχύτητα και την ακρίβεια, καθιστώντας το ένα πολύτιμο εργαλείο για τους προγραμματιστές. Επιπλέον, είναι διαθέσιμο με την άδεια Apache 2.0, επιτρέποντας σε οποιονδήποτε να το χρησιμοποιήσει και να το τροποποιήσει ελεύθερα.

Θέλετε να μάθετε περισσότερα;

Στην ουσία, το Mixtral 8x7B λειτουργεί ως μοντέλο μόνο για αποκωδικοποιητή, αξιοποιώντας μια μοναδική προσέγγιση όπου ένα μπλοκ προώθησης επιλέγει από οκτώ διακριτές

ομάδες

παραμέτρων, που αναφέρονται ως «ειδικοί». Αυτοί οι ειδικοί επιλέγονται δυναμικά από ένα δίκτυο δρομολογητών για την επεξεργασία κάθε διακριτικού, βελτιώνοντας την αποτελεσματικότητα και την απόδοση, ελαχιστοποιώντας παράλληλα τα υπολογιστικά έξοδα.

Ένα από τα βασικά πλεονεκτήματα του Mixtral έγκειται στην προσαρμοστικότητα και την επεκτασιμότητα του. Το Capable μπορεί να χειριστεί περιβάλλοντα έως και 32.000 tokens και να υποστηρίξει πολλές γλώσσες, όπως αγγλικά, γαλλικά, ιταλικά, γερμανικά και ισπανικά. Το Mixtral δίνει τη δυνατότητα στους προγραμματιστές να αντιμετωπίσουν ένα ευρύ φάσμα εργασιών με ευκολία και ακρίβεια.

Αυτό που πραγματικά ξεχωρίζει το Mixtral είναι η αναλογία απόδοσης προς κόστος. Με ένα εκπληκτικό σύνολο 46,7 δισεκατομμυρίων παραμέτρων, το Mixtral επιτυγχάνει αξιοσημείωτη απόδοση χρησιμοποιώντας μόνο ένα κλάσμα αυτών των παραμέτρων ανά διακριτικό, με αποτέλεσμα ταχύτερους χρόνους συμπερασμάτων και μειωμένα υπολογιστικά έξοδα.

Επιπλέον, η προεκπαίδευση της Mixtral σε εκτεταμένα σύνολα δεδομένων που εξάγονται από τον ανοιχτό ιστό εξασφαλίζει στιβαρότητα και ευελιξία σε εφαρμογές πραγματικού κόσμου. Είτε πρόκειται για δημιουργία κώδικα, μετάφραση γλώσσας ή ανάλυση συναισθήματος, το Mixtral προσφέρει εξαιρετικά αποτελέσματα σε διάφορα σημεία αναφοράς, ξεπερνώντας τα παραδοσιακά μοντέλα όπως το Llama 2 και μάλιστα ξεπερνώντας το GPT3.5 σε πολλές περιπτώσεις.

Πίστωση εικόνας

)

Για να ενισχύσει περαιτέρω τις δυνατότητές του, η Mistral AI παρουσίασε το Mixtral 8x7B Instruct, μια εξειδικευμένη παραλλαγή βελτιστοποιημένη για εργασίες που ακολουθούν τις οδηγίες. Επιτυγχάνοντας εντυπωσιακή βαθμολογία 8,30 στο MT-Bench, το Mixtral 8x7B Instruct ενισχύει τη θέση του ως κορυφαίο μοντέλο ανοιχτού κώδικα για εποπτευόμενη βελτιστοποίηση και βελτιστοποίηση προτιμήσεων.

Εκτός από την τεχνική του ικανότητα, το Mistral AI δεσμεύεται να εκδημοκρατίσει την πρόσβαση στο Mixtral συνεισφέροντας στο έργο vLLM, επιτρέποντας την απρόσκοπτη ενσωμάτωση και ανάπτυξη με εργαλεία ανοιχτού κώδικα. Αυτό δίνει τη δυνατότητα στους προγραμματιστές να αξιοποιήσουν τη δύναμη του Mixtral σε ένα ευρύ φάσμα εφαρμογών και πλατφορμών, οδηγώντας την καινοτομία και την πρόοδο στον τομέα της τεχνητής νοημοσύνης.

Το Groq AI, όχι το Grok, ψήνει τον

Elon Musk

με το “γρηγορότερο LLM” του

Πώς να χρησιμοποιήσετε το Mixtral 8x7B

Το Mixtral 8x7B είναι προσβάσιμο μέσω του τελικού σημείου mistral-small του Mistral, το οποίο βρίσκεται στο

φάσεις δοκιμής βήτα

μι. Εάν ενδιαφέρεστε να αποκτήσετε έγκαιρη πρόσβαση σε όλα τα παραγωγικά και ενσωματωμένα τελικά σημεία του Mistral, μπορείτε να

κανω ΕΓΓΡΑΦΗ

τώρα. Με την εγγραφή σας, θα είστε από τους πρώτους που θα γνωρίσετε τις πλήρεις δυνατότητες του Mixtral 8x7B και θα εξερευνήσετε τις καινοτόμες λύσεις του.

VIA:

DataConomy.com