Το GPT-3 είναι εξαιρετικό σε τυποποιημένες δοκιμές

Μεγάλα μοντέλα γλώσσας όπως το GPT-3 δίνουν στα

chatbot

μια ασυνήθιστη ικανότητα να δίνουν ανθρώπινες απαντήσεις στις διερευνητικές ερωτήσεις μας. Αλλά πόσο έξυπνοι είναι, αλήθεια; Μια νέα μελέτη από ψυχολόγους στο Πανεπιστήμιο της Καλιφόρνια-Λος Άντζελες δημοσιεύτηκε αυτή την εβδομάδα στο περιοδικό

φύση ανθρώπινη συμπεριφορά

διαπίστωσε ότι το γλωσσικό μοντέλο GPT-3 έχει καλύτερες συλλογιστικές δεξιότητες από έναν μέσο φοιτητή κολεγίου – αναμφισβήτητα χαμηλός πήχης.

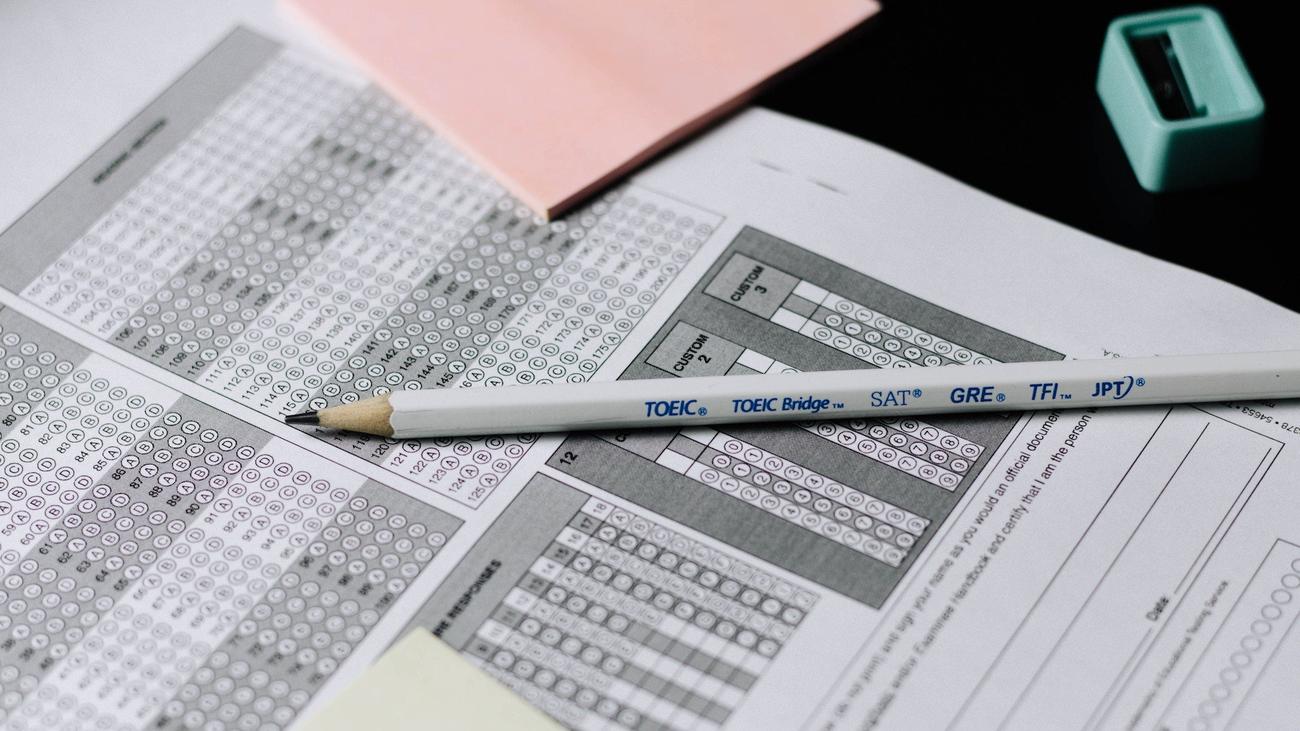

Η μελέτη διαπίστωσε ότι το GPT-3 είχε καλύτερες επιδόσεις από μια ομάδα 40 προπτυχιακών από το UCLA όταν επρόκειτο να απαντήσει σε μια σειρά ερωτήσεων που θα βλέπατε σε τυποποιημένες εξετάσεις όπως το SAT, το οποίο απαιτεί τη χρήση λύσεων από γνωστά προβλήματα για την επίλυση ενός νέου προβλήματος.

«Οι ερωτήσεις ζητούν από τους χρήστες να επιλέξουν ζεύγη λέξεων που μοιράζονται τον ίδιο τύπο σχέσεων. (Για παράδειγμα, στο πρόβλημα: «Αγάπη» είναι να «μισείς» όπως «πλούσιος» σε ποια λέξη; Η λύση θα ήταν «φτωχός»)» σύμφωνα με μια

δελτίο τύπου

. Ένα άλλο σύνολο αναλογιών ήταν προτροπές που προέρχονταν από ένα απόσπασμα μιας σύντομης ιστορίας και οι ερωτήσεις σχετίζονταν με πληροφορίες εντός αυτής της ιστορίας. Το δελτίο τύπου επισημαίνει: «Αυτή η διαδικασία, γνωστή ως αναλογικός συλλογισμός, θεωρείται από καιρό ότι είναι μια μοναδική ανθρώπινη ικανότητα».

Στην πραγματικότητα, οι βαθμολογίες GPT-3 ήταν καλύτερες από τη μέση βαθμολογία SAT για τους υποψήφιους κολεγίου. Το GPT-3 τα πήγε εξίσου καλά με τα ανθρώπινα υποκείμενα όταν επρόκειτο για λογικό συλλογισμό, δοκιμασμένο μέσω ενός συνόλου προβλημάτων που ονομάζονται

Raven’s Progressive Matrices

.

Δεν αποτελεί έκπληξη το γεγονός ότι το GPT-3 διαπρέπει στα SAT. Προηγούμενες μελέτες έχουν δοκιμάσει τη λογική ικανότητα του μοντέλου, ζητώντας του να δώσει μια σειρά από τυποποιημένες εξετάσεις όπως AP τεστ, LSAT, ακόμη και MCAT – και πέρασε με μεγάλη επιτυχία. Η πιο πρόσφατη έκδοση του μοντέλου γλώσσας,

GPT-4

που έχει την πρόσθετη δυνατότητα επεξεργασίας εικόνων, είναι

ακόμη καλύτερα

. Πέρυσι,

Ερευνητές της Google

διαπίστωσαν ότι μπορούν να βελτιώσουν τη λογική συλλογιστική τέτοιων γλωσσικών μοντέλων μέσω της προτροπής αλυσίδας σκέψης, όπου αναλύει ένα σύνθετο πρόβλημα σε μικρότερα βήματα.

[Related:

ChatGPT

‘s accuracy has gotten worse, study shows

]

Παρόλο που η τεχνητή νοημοσύνη σήμερα είναι θεμελιωδώς

προκλητικοί επιστήμονες υπολογιστών

Για να επανεξετάσουμε τα στοιχειώδη σημεία αναφοράς για τη νοημοσύνη των μηχανών, όπως το τεστ Turing, τα μοντέλα δεν είναι τέλεια.

Για παράδειγμα, μια μελέτη που δημοσιεύθηκε αυτή την εβδομάδα από μια ομάδα από

UC Riverside

διαπίστωσε ότι τα μοντέλα γλώσσας από την

Google

και το

OpenAI

παρείχαν ατελείς ιατρικές πληροφορίες ως απάντηση σε ερωτήματα ασθενών. Περαιτέρω μελέτες από επιστήμονες στο Στάνφορντ και στο Μπέρκλεϋ νωρίτερα αυτό το έτος διαπίστωσαν ότι το ChatGPT, όταν του ζητήθηκε να δημιουργήσει κώδικα ή να λύσει μαθηματικά προβλήματα, γινόταν πιο ατημέλητο με τις απαντήσεις του, για άγνωστους λόγους. Αναμεταξύ

κανονικοί άνθρωποι

ενώ το ChatGPT είναι διασκεδαστικό και δημοφιλές, δεν είναι πολύ πρακτικό για καθημερινή χρήση.

Και, εξακολουθεί να αποδίδει άσχημα στα οπτικά παζλ και στην κατανόηση της φυσικής και των χώρων του πραγματικού κόσμου. Για το σκοπό αυτό, η Google προσπαθεί να συνδυάσει πολυτροπικά μοντέλα γλώσσας με ρομπότ για να λύσει το πρόβλημα.

Είναι δύσκολο να πούμε αν αυτά τα μοντέλα σκέφτονται όπως εμείς—αν οι γνωστικές τους διαδικασίες είναι παρόμοιες με τις δικές μας. Τούτου λεχθέντος, μια τεχνητή νοημοσύνη που είναι καλή στη λήψη τεστ δεν είναι γενικά ευφυής όπως είναι ένας άνθρωπος. Είναι δύσκολο να πει κανείς πού βρίσκονται τα όριά τους και ποιες θα μπορούσαν να είναι οι δυνατότητές τους. Αυτό απαιτεί να ανοιχτούν και να εκτεθούν τα δεδομένα λογισμικού και εκπαίδευσης – μια θεμελιώδης κριτική που ασκούν οι ειδικοί σχετικά με το πόσο προσεκτικά προστατεύει το OpenAI την έρευνά του για το LLM.