Η NVIDIA θα ξεκινήσει την υιοθέτηση HBM3e το 1ο τρίμηνο του 2024 με το Hopper H200, το HBM4 αναμένεται να κάνει το ντεμπούτο του έως το 2026

Φαίνεται ότι η βιομηχανία HBM έχει επικεντρωθεί γύρω από τη NVIDIA, καθώς η TrendForce εκτιμά μια αγορά, όπου οι παραγγελίες AI της NVIDIA κυριαρχούν στην τρέχουσα και επόμενης γενιάς προσφορά HBM.

Η NVIDIA σχεδιάζει να κυριαρχήσει στις αγορές τεχνητής νοημοσύνης με χρήση της μνήμης HBM επόμενης γενιάς, οι προμηθευτές αρχίζουν να περιστρέφονται γύρω από το Team Green

Σύμφωνα με έρευνα αγοράς, η NVIDIA είναι έτοιμη να δώσει ένα δίκαιο μέρος των παραγγελιών της HBM στον κορεατικό γίγαντα Samsung, καθώς και οι δύο εταιρείες αρχίζουν να χτίζουν σε επιχειρηματικούς δεσμούς που θα μπορούσαν να αποδειχθούν ζωτικής σημασίας για τον κλάδο της τεχνητής νοημοσύνης.

Αναφέρθηκε τον Σεπτέμβριο ότι η Samsung κατάφερε να κερδίσει την εμπιστοσύνη της Team Green περνώντας πολλαπλούς ελέγχους πιστοποίησης για τα προϊόντα HBM της και η TrendForce αποκαλύπτει τώρα ότι η Samsung ενδέχεται να ολοκληρώσει τη διαδικασία μέχρι τον Δεκέμβριο, με τις παραγγελίες να αρχίζουν να ρέουν από την αρχή του επόμενου έτος. Η Samsung θα μπορούσε ενδεχομένως να είναι υπεύθυνη για τη φροντίδα των GPU της τρέχουσας γενιάς AI, όπως τα εξαιρετικά απαιτητικά H100 και A100.

Εκτός από το HBM3, η υιοθέτηση του προτύπου HBM3e επόμενης γενιάς βρίσκεται επίσης σε καλό δρόμο, καθώς πηγές του κλάδου αναφέρουν ότι προμηθευτές όπως η Micron, η SK Hynix και η Samsung έχουν ήδη ξεκινήσει τη διαδικασία δειγματοληψίας HBM3e και λέγεται ότι είναι αποφασιστικό Το αποτέλεσμα θα μπορούσε να έρθει κάπου το 2024. Για μια μικρή ανακεφαλαίωση, το ντεμπούτο του HBM3e αναμένεται στις GPU Blackwell AI της NVIDIA, οι οποίες φημολογείται ότι θα κυκλοφορήσουν μέχρι το δεύτερο τρίμηνο του 2024, και όσον αφορά την απόδοση, θα φέρει αποφασιστικές βελτιώσεις όσον αφορά την απόδοση ανά watt, μέσω της υιοθέτησης ενός σχεδίου chiplet.

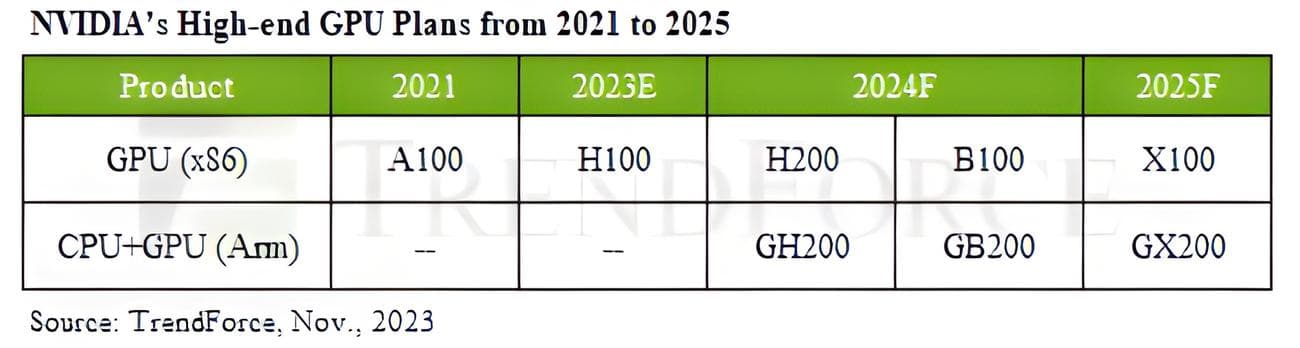

Προχωρώντας στο ενδιαφέρον κομμάτι, η NVIDIA έχει προγραμματίσει πολλά για τους πελάτες της το 2024, αφού η εταιρεία έχει ήδη ανακοινώσει την GPU H200 Hopper, η οποία αναμένεται να γίνει μαζική υιοθέτηση μέχρι το επόμενο έτος, ακολουθούμενη από την παρουσίαση του B100 “Blackwell” GPU AI, και οι δύο θα βασίζονται στην τεχνολογία μνήμης HBM3e.

Εκτός από τη συμβατική διαδρομή, η NVIDIA φημολογείται επίσης ότι θα αποκαλύψει CPU που βασίζονται σε ARM για το τμήμα AI, οι οποίες θα δημιουργήσουν διαφοροποίηση στις αγορές, παράλληλα με την ενίσχυση του ανταγωνισμού. Η Intel και η AMD αναμένεται επίσης να παρουσιάσουν τις αντίστοιχες λύσεις AI τους, με αξιοσημείωτες αναφορές να είναι οι GPU AMD Instinct επόμενης γενιάς και οι επιταχυντές Gaudi AI της Intel, με τη μνήμη HBM3e.

Τέλος, η TrendForce δίνει μια υποβάθμιση για το τι μπορούμε να περιμένουμε με το HBM4, ειδικά από το γεγονός ότι το επερχόμενο πρότυπο μνήμης θα συνοδεύεται από μια πλήρη ανανέωση όσον αφορά τις διαμορφώσεις ενσωματωμένης μήτρας, καθώς φημολογείται ότι το βασικό λογικό καλούπι θα διαθέτει 12nm επεξεργάζεται γκοφρέτα για πρώτη φορά και θα λειτουργήσει ως οδηγός πίσω από τη συσκευασμένη 3D DRAM/GPU, δημιουργώντας ένα περιβάλλον συνεργασίας μεταξύ χυτηρίων και προμηθευτών μνήμης. Το HBM4 αναμένεται να σηματοδοτήσει τη μετάβαση της επόμενης γενιάς όσον αφορά την υπολογιστική ισχύ και θα μπορούσε να είναι το κλειδί για μελλοντικές ανακαλύψεις στον κλάδο της τεχνητής νοημοσύνης.

Πηγή ειδήσεων:

TrendForce

VIA:

wccftech.com