Ο πιο τρομερός υπερυπολογιστής όλων των εποχών ζεσταίνεται για το ChatGPT 5 — χιλιάδες «παλιοί» επιταχυντές GPU AMD συνέθεσαν μοντέλα παραμέτρων 1 τρισεκατομμυρίου

Ο πιο ισχυρός υπερυπολογιστής στον κόσμο έχει χρησιμοποιήσει λίγο περισσότερο από το 8% των GPU με τις οποίες είναι εξοπλισμένη για την

εκπαίδευση

ενός μοντέλου μεγάλης γλώσσας (LLM) που περιέχει ένα τρισεκατομμύριο παραμέτρους – συγκρίσιμες με το

GPT-4

του OpenAI.

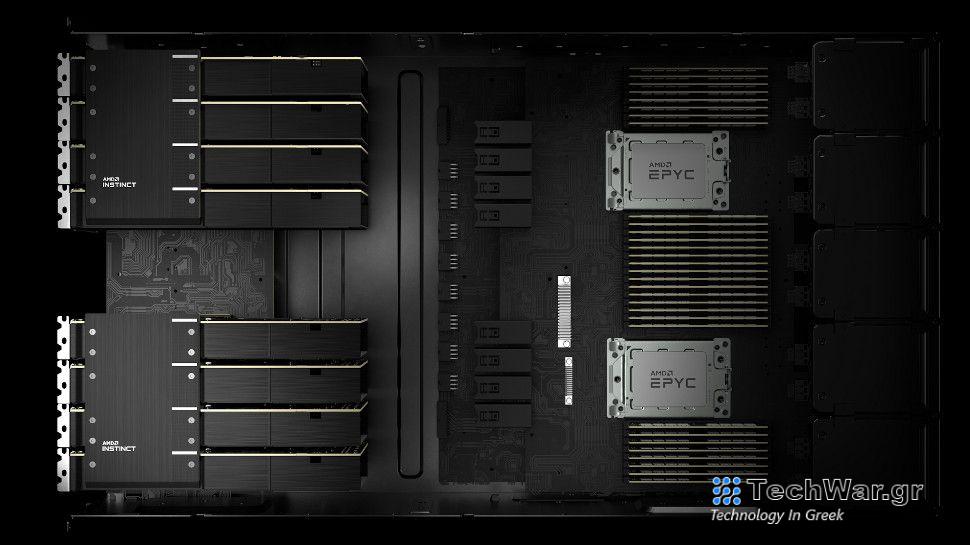

Η Frontier, που εδρεύει στο Εθνικό

Εργα

στήριο Oak Ridge, χρησιμοποίησε 3.072 από τις GPU της AMD Radeon Instinct για να εκπαιδεύσει ένα σύστημα AI σε κλίμακα τρισεκατομμυρίων παραμέτρων και χρησιμοποίησε 1.024 από αυτές τις GPU (περίπου 2,5%) για να εκπαιδεύσει ένα μοντέλο παραμέτρων 175 δισεκατομμυρίων , ουσιαστικά το ίδιο μέγεθος με το ChatGPT.

Οι ερευνητές χρειάστηκαν τουλάχιστον 14 TB RAM για να επιτύχουν αυτά τα αποτελέσματα, σύμφωνα με

το χαρτί τους

, αλλά κάθε GPU MI250X είχε μόνο 64 GB VRAM, που σημαίνει ότι οι ερευνητές έπρεπε να ομαδοποιήσουν πολλές GPU μαζί. Αυτό εισήγαγε μια άλλη πρόκληση με τη μορφή παραλληλισμού, ωστόσο, που σημαίνει ότι τα στοιχεία έπρεπε να επικοινωνούν πολύ καλύτερα και πιο αποτελεσματικά καθώς αυξανόταν το συνολικό μέγεθος των πόρων που χρησιμοποιούνται για την εκπαίδευση του LLM.

Θέτοντας σε λειτουργία τον πιο ισχυρό υπερυπολογιστή στον κόσμο

Τα LLM δεν εκπαιδεύονται συνήθως σε υπερ

υπολογιστές

, αλλά εκπαιδεύονται σε εξειδικευμένους διακομιστές και απαιτούν πολύ περισσότερες GPU. Το ChatGPT, για παράδειγμα, εκπαιδεύτηκε σε περισσότερες από 20.000 GPU, σύμφωνα με

TrendForce

. Αλλά οι ερευνητές ήθελαν να δείξουν εάν θα μπορούσαν να εκπαιδεύσουν έναν υπερυπολογιστή πολύ πιο γρήγορα και αποτελεσματικά, αξιοποιώντας διάφορες τεχνικές που κατέστησαν δυνατές από την

αρχιτεκτονική

των υπερυπολογιστών.

Οι επιστήμονες χρησιμοποίησαν έναν συνδυασμό παραλληλισμού τανυστών – ομάδες GPU που μοιράζονται τα μέρη του ίδιου τανυστή – καθώς και παραλληλισμό αγωγών – ομάδες GPU που φιλοξενούν γειτονικά στοιχεία. Χρησιμοποίησαν επίσης παραλληλισμό δεδομένων για να καταναλώσουν ταυτόχρονα μεγάλο αριθμό διακριτικών και μεγαλύτερο αριθμό υπολογιστικών πόρων. Το συνολικό αποτέλεσμα ήταν να επιτευχθεί πολύ πιο γρήγορος χρόνος.

Για το μοντέλο παραμέτρων των 22 δισεκατομμυρίων, πέτυχαν μέγιστη απόδοση 38,38% (73,5 TFLOPS), 36,14% (69,2 TFLOPS) για το μοντέλο παραμέτρων των 175 δισεκατομμυρίων και 31,96% μέγιστη απόδοση (61,2 TFLOPS) για το μοντέλο 1 τριών παραμέτρων .

Πέτυχαν επίσης 100% χαμηλή απόδοση κλιμάκωσης, καθώς και ισχυρή απόδοση κλιμάκωσης 89,93% για το μοντέλο 175 δισεκατομμυρίων και ισχυρή απόδοση κλιμάκωσης 87,05% για το μοντέλο παραμέτρων 1 τρισεκατομμυρίου.

Αν και οι ερευνητές ήταν ανοιχτοί σχετικά με τους υπολογιστικούς πόρους που χρησιμοποιήθηκαν και τις τεχνικές που εμπλέκονται, παρέλειψαν να αναφέρουν τα χρονοδιαγράμματα που εμπλέκονται στην εκπαίδευση ενός LLM με αυτόν τον τρόπο.

Το TechRadar Pro ζήτησε από τους ερευνητές τους χρόνους, αλλά δεν έχουν απαντήσει τη στιγμή της σύνταξης.

VIA:

TechRadar.com/