Η εκπληκτική απόδοση του LLM 1-Bit της Microsoft

Με τη νέα τεχνολογία LLM 1-bit, η Microsoft μπορεί να έσπασε τον κώδικα για τη δημιουργία ισχυρού AI πίσω από chatbot και γλωσσικά εργαλεία που μπορούν να χωρέσουν στην τσέπη σας, να τρέχουν αστραπιαία και να σώσουν τον πλανήτη.

Εντάξει, κόψτε το μέρος του πλανήτη, αλλά είναι πραγματικά μεγάλη υπόθεση!

Τα παραδοσιακά LLM, τα ισχυρά μοντέλα AI πίσω από εργαλεία όπως το ChatGPT και το Gemini, χρησιμοποιούν συνήθως

Αριθμοί κινητής υποδιαστολής 16-bit ή ακόμα και 32-bit

για να αναπαραστήσουν τις παραμέτρους ή τα βάρη του μοντέλου. Αυτά τα βάρη καθορίζουν τον τρόπο με τον οποίο το μοντέλο επεξεργάζεται τις πληροφορίες. Το LLM 1-bit της Microsoft υιοθετεί μια ριζικά διαφορετική προσέγγιση κβαντίζοντας (μειώνοντας την ακρίβεια) αυτά τα βάρη σε

μόλις 1,58 bit

.

Με ένα LLM 1 bit, κάθε βάρος μπορεί να λάβει μόνο μία από τις τρεις τιμές: -1, 0 ή 1.

Αυτό

μπορεί να φαίνεται δραστικά περιοριστικό

αλλά οδηγεί σε

αξιοσημείωτα πλεονεκτήματα

.

Τα παραδοσιακά μοντέλα τεχνητής νοημοσύνης χρησιμοποιούν ογκώδεις αριθμούς 16 bit (ή περισσότερους) για υπολογισμούς, αλλά το LLM 1 bit της Microsoft το μειώνει δραστικά

(

Πίστωση εικόνας

)

Ποια είναι η φασαρία για τα LLM 1-Bit;

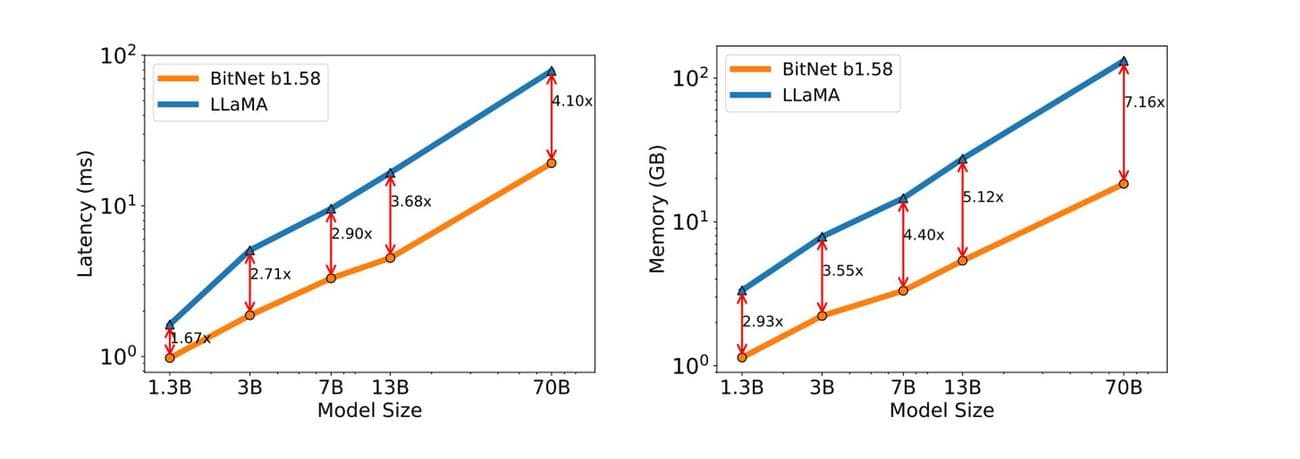

Οι μειωμένες απαιτήσεις πόρων των LLM 1 bit θα μπορούσαν να επιτρέψουν εφαρμογές τεχνητής νοημοσύνης σε ένα ευρύτερο φάσμα συσκευών, ακόμη και σε αυτές με περιορισμένη μνήμη ή υπολογιστική ισχύ. Αυτό θα μπορούσε να οδηγήσει σε ευρύτερη υιοθέτηση της τεχνητής νοημοσύνης σε διάφορους κλάδους.

Μικρότεροι εγκέφαλοι

σημαίνω

Το AI μπορεί να τρέξει σε μικρότερες συσκευές

: Το τηλέφωνό σας, το έξυπνο ρολόι, εσείς το πείτε.

Η απλοποιημένη αναπαράσταση των βαρών σε ένα LLM 1 bit μεταφράζεται σε μεγαλύτερες ταχύτητες συμπερασμάτων – τη διαδικασία δημιουργίας κειμένου, μετάφρασης γλωσσών ή εκτέλεσης άλλων εργασιών που σχετίζονται με τη γλώσσα.

Οι απλούστεροι υπολογισμοί σημαίνουν το

Το AI σκέφτεται και ανταποκρίνεται πολύ πιο γρήγορα

.

Η υπολογιστική απόδοση των LLM 1 bit οδηγεί επίσης σε χαμηλότερη κατανάλωση ενέργειας, καθιστώντας τα πιο φιλικά προς το περιβάλλον και οικονομικά αποδοτικά στη λειτουργία τους.

Λιγότερη υπολογιστική ισχύς ισοδυναμεί με λιγότερη ενέργεια που καταναλώνεται

. Αυτή είναι μια σημαντική νίκη για την περιβαλλοντικά συνειδητή τεχνολογία, ένα απόλυτο βήμα για να γίνει η τεχνητή νοημοσύνη πράσινη.

Πέρα από όλα αυτά, τα μοναδικά υπολογιστικά χαρακτηριστικά των LLM 1 bit ανοίγουν δυνατότητες σχεδιασμού εξειδικευμένου υλικού βελτιστοποιημένου για τις λειτουργίες τους, οδηγώντας δυνητικά σε ακόμη περαιτέρω προόδους στην απόδοση και την αποδοτικότητα.

Γνωρίστε το BitNet LLM της Microsoft

Η εφαρμογή αυτής της τεχνολογίας από τη Microsoft ονομάζεται

BitNet b1.58

. Η πρόσθετη τιμή 0 (σε σύγκριση με πραγματικές υλοποιήσεις 1 bit) είναι ένα κρίσιμο στοιχείο που βελτιώνει την απόδοση του μοντέλου.

Το BitNet b1.58 επιδεικνύει αξιοσημείωτα αποτελέσματα, προσεγγίζοντας την απόδοση των παραδοσιακών LLM σε ορισμένες περιπτώσεις, ακόμη και με σοβαρή κβαντοποίηση.

Το BitNet b1.58 μπορεί σχεδόν να ταιριάζει με την απόδοση των παραδοσιακών μοντέλων τεχνητής νοημοσύνης παρά την απλούστερη μορφή

(

Πίστωση εικόνας

)

Σπάζοντας το φράγμα των 16 bit

Όπως αναφέρθηκε προηγουμένως, τα παραδοσιακά LLM χρησιμοποιούν τιμές κινητής υποδιαστολής 16-bit (FP16) για να αναπαραστήσουν τα βάρη μέσα στο μοντέλο. Παρόλο που προσφέρει υψηλή ακρίβεια, αυτή η προσέγγιση μπορεί να είναι εντατική σε μνήμη και υπολογιστικά ακριβή. Το BitNet b1.58 ρίχνει ένα κλειδί σε αυτό το παράδειγμα υιοθετώντας μια τριμερή αναπαράσταση 1,58-bit για τα βάρη.

Αυτό σημαίνει ότι κάθε βάρος μπορεί να λάβει μόνο τρεις διαφορετικές τιμές:

- -1: Αντιπροσωπεύει αρνητική επίδραση στην απόδοση του μοντέλου

- 0: Δεν αντιπροσωπεύει καμία επίδραση στην έξοδο

- +1: Αντιπροσωπεύει θετική επιρροή στην έξοδο

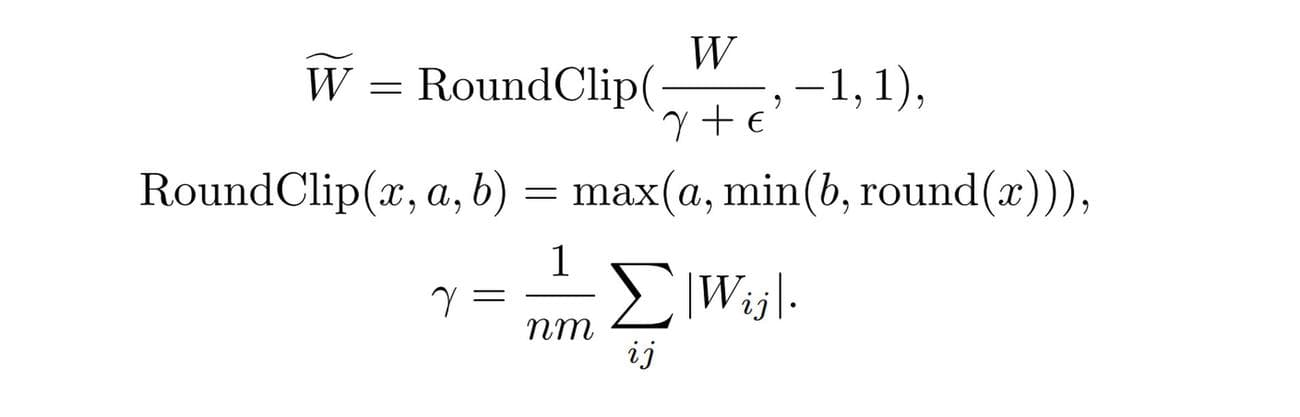

Αποτελεσματική χαρτογράφηση βαρών

Η μετάβαση από έναν συνεχή (FP16) σε ένα διακριτό (τριαδικό) χώρο βάρους απαιτεί προσεκτική εξέταση. Το BitNet b1.58 χρησιμοποιεί α

ειδική συνάρτηση κβαντισμού

για να επιτευχθεί αυτή η χαρτογράφηση αποτελεσματικά. Αυτή η συνάρτηση λαμβάνει τις αρχικές τιμές βάρους FP16 και εφαρμόζει έναν συγκεκριμένο αλγόριθμο για να προσδιορίσει την πλησιέστερη αντίστοιχη τριμερή τιμή (-1, 0 ή +1). Το κλειδί εδώ είναι να ελαχιστοποιηθεί η υποβάθμιση της απόδοσης που προκαλείται από αυτήν τη μετατροπή.

Ακολουθεί μια απλοποιημένη ανάλυση της συνάρτησης

-

Απολέπιση

: Η συνάρτηση πρώτα κλιμακώνει ολόκληρο τον πίνακα βάρους με βάση τη μέση απόλυτη τιμή του. Αυτό διασφαλίζει ότι τα βάρη είναι κεντραρισμένα γύρω από το μηδέν -

Στρογγύλεμα

: Στη συνέχεια, κάθε τιμή βάρους στρογγυλοποιείται στην πλησιέστερη ακέραια τιμή μεταξύ -1, 0 και +1. Αυτό μεταφράζει τα κλιμακούμενα βάρη στο διακριτό τριμερές σύστημα

Το BitNet b1.58 χρησιμοποιεί έξυπνα στοιχεία παρόμοια με το μοντέλο ανοιχτού κώδικα LLaMA για εύκολη ενσωμάτωση

(

Πίστωση εικόνας

)

Δείτε τον αναλυτικό τύπο στο

Ερευνητικό έγγραφο 1-Bit LLM της Microsoft

.

Κλιμάκωση ενεργοποίησης

Οι ενεργοποιήσεις, ένα άλλο κρίσιμο στοιχείο των LLM, υποβάλλονται επίσης σε μια διαδικασία κλιμάκωσης στο BitNet b1.58. Κατά τη διάρκεια της εκπαίδευσης και των συμπερασμάτων, οι ενεργοποιήσεις κλιμακώνονται σε ένα συγκεκριμένο εύρος (π.χ. -0,5 έως +0,5).

Αυτή η κλιμάκωση εξυπηρετεί δύο σκοπούς:

-

Εκτέλεση

Βελτιστοποίηση: Οι ενεργοποιήσεις κλιμάκωσης συμβάλλουν στη διατήρηση της βέλτιστης απόδοσης στο περιβάλλον μειωμένης ακρίβειας του BitNet b1.58 -

Απλοποίηση

: Το επιλεγμένο εύρος κλιμάκωσης απλοποιεί την υλοποίηση και τη βελτιστοποίηση σε επίπεδο συστήματος χωρίς να εισάγει σημαντικά μειονεκτήματα απόδοσης

Συμβατότητα ανοιχτού κώδικα

Η ερευνητική κοινότητα LLM ευδοκιμεί στη συνεργασία ανοιχτού κώδικα. Για να διευκολυνθεί η ενσωμάτωση με τα υπάρχοντα πλαίσια, το BitNet b1.58 υιοθετεί στοιχεία παρόμοια με αυτά που βρίσκονται στη δημοφιλή αρχιτεκτονική μοντέλων LLaMA. Αυτό περιλαμβάνει στοιχεία όπως:

-

RMSNorm

: Μια τεχνική κανονικοποίησης για τη σταθεροποίηση της προπονητικής διαδικασίας -

SwiGLU

: Μια λειτουργία ενεργοποίησης που προσφέρει πλεονεκτήματα απόδοσης -

Περιστροφικές ενσωματώσεις

: Μια μέθοδος για την αναπαράσταση λέξεων και θέσεων μέσα στο μοντέλο -

Άρση προκαταλήψεων

: Απλοποίηση της αρχιτεκτονικής του μοντέλου

Με την ενσωμάτωση αυτών των στοιχείων που μοιάζουν με το LLaMA, το BitNet b1.58 γίνεται εύκολα ενσωματώσιμο με δημοφιλείς βιβλιοθήκες λογισμικού ανοιχτού κώδικα LLM, ελαχιστοποιώντας την προσπάθεια που απαιτείται για υιοθέτηση από την ερευνητική κοινότητα.

Πίστωση επιλεγμένης εικόνας

:

Freepik

.

VIA:

DataConomy.com