Η Μόνα Λίζα ως Οφηλία: Μια νέα προσέγγιση με τη χρήση της τεχνολογίας AI

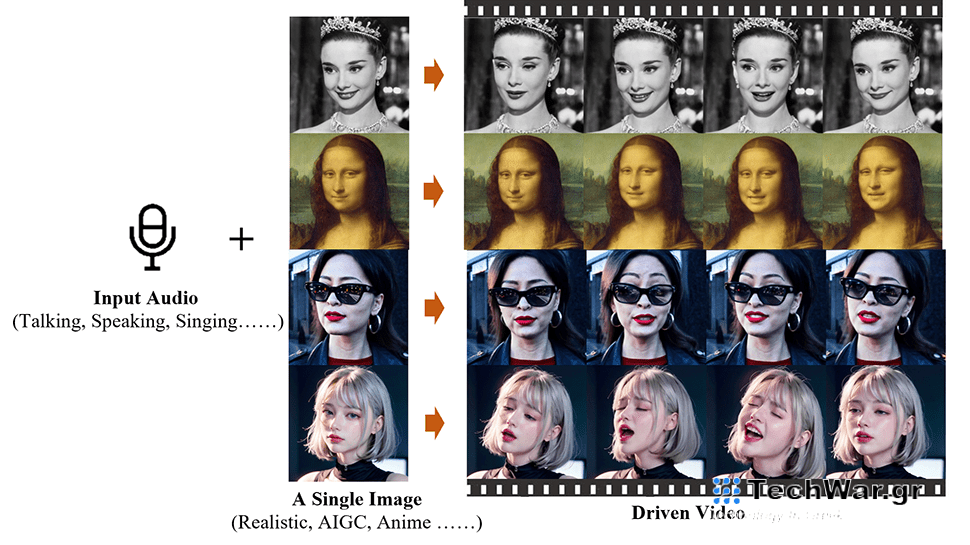

Κινέζοι μηχανικοί στο Ινστιτούτο Ευφυών Υπολογιστών, ο Όμιλος Alibaba, ανέπτυξαν μια εφαρμογή τεχνητής νοημοσύνης που ονομάζεται Emote Portrait Live, η οποία μπορεί να κινήσει μια ακίνητη φωτογραφία ενός προσώπου και να τη συγχρονίσει με ένα κομμάτι ήχου.

Η τεχνολογία πίσω από αυτό βασίζεται στις παραγωγικές δυνατότητες των μοντέλων διάχυσης (μαθηματικά μοντέλα που χρησιμοποιούνται για να περιγράψουν τον τρόπο με τον οποίο τα πράγματα εξαπλώνονται ή διαχέονται με την πάροδο του χρόνου), τα οποία μπορούν να συνθέσουν απευθείας βίντεο κεφαλιών χαρακτήρων από μια παρεχόμενη εικόνα και οποιοδήποτε ηχητικό κλιπ. Αυτή η διαδικασία παρακάμπτει την ανάγκη για πολύπλοκες προεπεξεργασίες ή ενδιάμεσες αναπαραστάσεις, απλοποιώντας έτσι τη δημιουργία ομιλούντων βίντεο.

Η πρόκληση έγκειται στην καταγραφή των αποχρώσεων και της ποικιλομορφίας των κινήσεων του ανθρώπινου προσώπου κατά τη διάρκεια της σύνθεσης βίντεο. Οι παραδοσιακές μέθοδοι το απλοποιούν επιβάλλοντας περιορισμούς στην τελική έξοδο βίντεο, όπως η χρήση τρισδιάστατων μοντέλων για τον περιορισμό των σημείων κλειδιών του προσώπου ή η εξαγωγή ακολουθιών κίνησης της κεφαλής από τα βασικά βίντεο για την καθοδήγηση της συνολικής κίνησης. Ωστόσο, αυτοί οι περιορισμοί μπορεί να περιορίσουν τη φυσικότητα και τον πλούτο των εκφράσεων του προσώπου που προκύπτουν.

Όχι χωρίς προκλήσεις

Ο στόχος της ερευνητικής ομάδας είναι να αναπτύξει ένα πλαίσιο ομιλούντος κεφαλιού που μπορεί να συλλάβει ένα ευρύ φάσμα ρεαλιστικών εκφράσεων του προσώπου, συμπεριλαμβανομένων λεπτών μικροεκφράσεων, και να επιτρέπει φυσικές κινήσεις του κεφαλιού.

Ωστόσο, η ενοποίηση του ήχου με τα μοντέλα διάχυσης παρουσιάζει τις δικές της προκλήσεις λόγω της διφορούμενης σχέσης μεταξύ ήχου και εκφράσεων του προσώπου. Αυτό μπορεί να οδηγήσει σε αστάθεια στα βίντεο που παράγονται από το μοντέλο, συμπεριλαμβανομένων παραμορφώσεων του προσώπου ή τρεμούλιασμα μεταξύ των καρέ βίντεο. Για να ξεπεραστεί αυτό, οι ερευνητές συμπεριέλαβαν σταθερούς μηχανισμούς ελέγχου στο μοντέλο τους, συγκεκριμένα έναν ελεγκτή ταχύτητας και έναν ελεγκτή περιοχής προσώπου, για να βελτιώσουν τη σταθερότητα κατά τη διαδικασία παραγωγής.

Παρά τις δυνατότητες αυτής της τεχνολογίας, υπάρχουν ορισμένα μειονεκτήματα. Η διαδικασία είναι πιο χρονοβόρα από μεθόδους που δεν χρησιμοποιούν μοντέλα διάχυσης. Επιπλέον, δεδομένου ότι δεν υπάρχουν σαφή σήματα ελέγχου που να καθοδηγούν την κίνηση του χαρακτήρα, το μοντέλο μπορεί να δημιουργήσει ακούσια άλλα μέρη του σώματος, όπως τα χέρια, με αποτέλεσμα τεχνουργήματα στο βίντεο.

Η ομάδα έχει

δημοσίευσε

ένα χαρτί για την εργασία του για το

arXiv

διακομιστή προεκτύπωσης και

αυτόν τον ιστότοπο

φιλοξενεί πολλά άλλα βίντεο που παρουσιάζουν τις δυνατότητες του Emote Portrait Live, συμπεριλαμβανομένων των κλιπ των Joaquin Phoenix (ως The Joker), Leonardo DiCaprio και Audrey Hepburn.

Μπορείτε να παρακολουθήσετε τη Μόνα Λίζα να απαγγέλλει τον μονόλογο της Ρόζαλιντ από τον Σαίξπηρ

Οπως σου αρέσει

Πράξη 3, Σκηνή 2, παρακάτω.

VIA:

TechRadar.com/