Οι γερουσιαστές θέλουν να εξαιρέσουν την τεχνητή νοημοσύνη από τις Προστασίες του Άρθρου 230

Related Posts

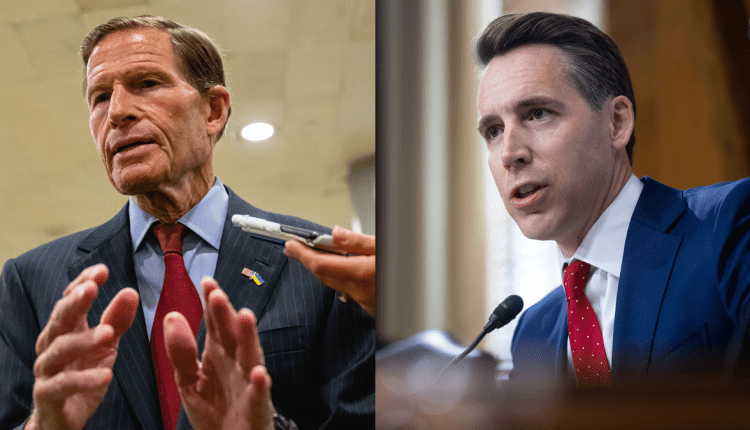

Δύο Αμερικανοί γερουσιαστές ενώνουν τα χέρια σε όλο το διάδρομο για να προσπαθήσουν να διαχωρίσουν την τεχνητή νοημοσύνη από το υπόλοιπο Διαδίκτυο. Οι γερουσιαστές Josh Hawley και Richard Blumenthal έχουν παρουσιάσει

νέα νομοθεσία

που, εάν εγκριθεί, θα απαλλάσσει την τεχνητή νοημοσύνη από τις προστασίες της Ενότητας 230. Το προτεινόμενο νομοσχέδιο θα αφήσει τις εταιρείες τεχνητής νοημοσύνης πιθανώς υπεύθυνες για το συχνά λανθασμένο (

Το TBD ίσως μερικές φορές δυσφημιστικό

) περιεχόμενο που παράγουν μεγάλα γλωσσικά μοντέλα και άλλα εργαλεία παραγωγής τεχνητής νοημοσύνης.

Το μέτρο, που τιτλοφορείται ευθέως «No Section 230 Immunity for AI Act», έρχεται καθώς το ερώτημα για το ποιος είναι υπεύθυνος για τις δημιουργίες της τεχνητής νοημοσύνης συζητείται έντονα – χωρίς ακόμη σαφή νομική απάντηση.

«Οι εταιρείες τεχνητής νοημοσύνης θα πρέπει να αναγκαστούν να αναλάβουν την ευθύνη για επιχειρηματικές αποφάσεις καθώς αναπτύσσουν προϊόντα – χωρίς καμία νομική ασπίδα του Άρθρου 230», δήλωσε ο Δημοκρατικός Μπλούμενταλ στο Κονέκτικατ.

δήλωση τύπου

. Ο Ρεπουμπλικανός από το Μιζούρι Hawley πρόσθεσε: «Δεν μπορούμε να κάνουμε τα ίδια λάθη με τη γενετική τεχνητή νοημοσύνη όπως κάναμε με τη Big Tech στην Ενότητα 230…οι εταιρείες πρέπει να λογοδοτήσουν».

Ο Blumenthal είχε υπονοήσει τη νέα του νομοθεσία κατά τη διάρκεια μιας δικαστικής επιτροπής της Γερουσίας

ακρόαση

στον πραγματικό κόσμο

επιπτώσεις της τεχνητής νοημοσύνης στα ανθρώπινα δικαιώματα

νωρίτερα αυτή την εβδομάδα. Κατά τη διάρκεια της ερώτησής του, ο Blumenthal ισχυρίστηκε ότι οι εταιρείες μέσων κοινωνικής δικτύωσης είχαν επωφεληθεί από μια υπερβολικά ευρεία ερμηνεία του Άρθρου 230 και υποστήριξε ότι ήταν κρίσιμο το Κογκρέσο να μην επαναλάβει αυτό το σενάριο για την αναδυόμενη εποχή της γενετικής τεχνητής νοημοσύνης.

«Πρέπει να διευκρινίσουμε την Ενότητα 230 για να πούμε ότι δεν ισχύει για την τεχνητή νοημοσύνη γιατί αν δεν το κάνουμε, βρισκόμαστε σε έναν εντελώς νέο κόσμο πληγών», είπε ο Blumenthal.

Η ίδια η πρόσφατα προτεινόμενη νομοθεσία θα τροποποιούσε το 230 με το ακόλουθο κείμενο:

Καμία επίδραση σε αξιώσεις που σχετίζονται με γενετική τεχνητή νοημοσύνη—Τίποτα σε αυτό το τμήμα…δεν θα ερμηνεύεται ότι βλάπτει ή περιορίζει οποιαδήποτε αξίωση σε αστική αγωγή ή κατηγορία σε ποινική δίωξη που ασκείται βάσει ομοσπονδιακής ή πολιτειακής νομοθεσίας κατά του παρόχου μιας διαδραστικής υπηρεσίας υπολογιστή εάν η συμπεριφορά στην οποία βασίζεται η αξίωση ή χρέωση περιλαμβάνει τη χρήση ή την παροχή γενετικής τεχνητής νοημοσύνης από τη διαδραστική υπηρεσία υπολογιστή.

Άρθρο 230 του

Νόμος για την ευπρέπεια των επικοινωνιών

θεωρείται ευρέως

ο θεμελιώδης νόμος του Διαδικτύου

. Επιτρέπει στους ιστότοπους κοινωνικής δικτύωσης, τις μηχανές αναζήτησης, τα φόρουμ και τις ενότητες σχολίων να υπάρχουν χωρίς πλατφόρμες ή παρόχους διαδικτύου να λαμβάνονται υπόψη για το περιεχόμενο που δημοσιεύουν οι χρήστες τους. Από πολλές απόψεις, αν και ελαττωματικό, είναι

ο

πολιτική που

επιτρέπει οποιοδήποτε βαθμό ελευθερίας του λόγου στο διαδίκτυο

και είναι σημαντικό.

Όμως, τα τελευταία χρόνια, έχει αντιμετωπιστεί η ώθηση από πολιτικούς και των δύο κομμάτων —σε μεγάλο βαθμό με βάση τον τρόπο με τον οποίο προστατεύει τις μεγάλες εταιρείες τεχνολογίας καθώς η παραπληροφόρηση πολλαπλασιάζεται στο Διαδίκτυο. Ο Πρόεδρος Μπάιντεν έχει επανειλημμένα πει

θέλει αναμόρφωση του κανονισμού

. Οι Ρεπουμπλικάνοι νομοθέτες (και ορισμένοι Δημοκρατικοί), εν τω μεταξύ, έχουν κάνει πολλές προσπάθειες για να καταργήσουν πλήρως τον κανόνα. Ο γερουσιαστής Hawley, ειδικότερα,

έχει έρθει για 230 πριν

. (Σε αυτή την τελευταία προσπάθεια, θα μπορούσε να αξιοποιήσει το ανοιχτό ζήτημα της λογοδοσίας της τεχνητής νοημοσύνης ως στρατηγική για την αποδυνάμωση της προστατευτικής ασπίδας του 230 συνολικά.)

Ανεξάρτητα από όλα τα λάθη που έχει πάρει το Άρθρο 230, το Ανώτατο Δικαστήριο

πρόσφατα επέλεξε να διατηρήσει τη διάταξη

άθικτος. Τον Μάιο, η SCOTUS απέρριψε μια σημαντική υπόθεση και αρνήθηκε να εξετάσει το ζήτημα. Αλλά επειδή το 230 εξακολουθεί να είναι ο νόμος της χώρας, αυτό δεν σημαίνει ότι ισχύει απαραίτητα για την τεχνητή νοημοσύνη. Αν ρωτήσετε τους ανθρώπους που έγραψαν την αρχική πολιτική του 1996, δεν το κάνουν.

Ο γερουσιαστής Ron Wyden μαζί με τον πρώην πρόεδρο της SEC και μέλος του Κογκρέσου, Chris Cox, ο οποίος συνέγραψε την ενότητα 230

έχουν υποστηρίξει

η διάταξη δεν θα πρέπει να ισχύει για το κείμενο, το βίντεο ή τις εικόνες που εκπέμπουν προγράμματα όπως το

ChatGPT

του

OpenAI

ή το DALL-E. “Το τμήμα 230 αφορά την προστασία των χρηστών και των τοποθεσιών για τη φιλοξενία και την οργάνωση της ομιλίας των χρηστών” και “δεν έχει καμία σχέση με την προστασία των εταιρειών από τις συνέπειες των δικών τους ενεργειών και προϊόντων”, δήλωσε ο Wyden σε μια δήλωση.

στο Reuters

για το θέμα τον Απρίλιο.

Η προτεινόμενη νομοθεσία των Hawley και Blumenthal θα ήταν ένας τρόπος για να εδραιωθεί μια εξαίρεση για την τεχνητή νοημοσύνη στο νόμο. Ωστόσο, η πράξη θα μπορούσε να αποδειχθεί εντελώς περιττή, σύμφωνα με

Τζεφ Κόσεφ

καθηγητής δικαίου της κυβερνοασφάλειας στη Ναυτική Ακαδημία των ΗΠΑ και συγγραφέας ενός βιβλίου για το 2019 για την Ενότητα 230,

Οι είκοσι έξι λέξεις που δημιούργησαν το Διαδίκτυο

. «Δεν ξέρουμε αν αυτό θα ήταν καν απαραίτητο», είπε ο Kosseff για τον εκκρεμή λογαριασμό σε τηλεφωνική επικοινωνία με την Gizmodo. Ανέφερε τη θέση των Γουάιντεν και Κοξ και σημείωσε ότι δεν υπάρχει νομικό τεστ που να δείχνει ποια στάση θα μπορούσαν να τηρήσουν τα αμερικανικά δικαστήρια.

Ομολογουμένως, η Ενότητα 230 προστατεύει μόνο τους διαδικτυακούς παρόχους και πλατφόρμες στην περίπτωση περιεχομένου στο οποίο δεν συνεισφέρουν άμεσα, εξήγησε ο Kosseff. Και υπάρχει επιχείρημα ότι οι εταιρείες τεχνητής νοημοσύνης «συμβάλλουν» κατά κάποιο τρόπο σε όλα όσα παράγουν αυτά τα προγράμματα.

Είτε μέσω νομοθεσίας είτε μέσω άλλης διαδρομής, εάν η Ενότητα 230 δεν ισχύει για περιεχόμενο τεχνητής νοημοσύνης,

όλα θα έμεναν

υπόκειται στους υπάρχοντες νόμους περί δυσφήμισης, εξήγησε ο Kosseff. Νωρίτερα αυτό το μήνα, ένας παρουσιαστής του ραδιοφώνου της Γεωργίας

κατέθεσε την πρώτη υπόθεση συκοφαντίας κατά του OpenAI

σχετικά με το ChatGPT φέρεται να «παραισθάνεται» και να παράγει ψευδές κείμενο ότι ο παρουσιαστής του ραδιοφώνου είχε κατηγορηθεί για υπεξαίρεση χρημάτων. Άλλοι έχουν

απείλησε με παρόμοια δράση

. Κανένας από αυτούς τους ισχυρισμούς δεν έχει ακόμη καταλήξει σε ετυμηγορία.

Το επίσημο άνοιγμα των κατασκευαστών τεχνητής νοημοσύνης σε ευθύνη για ό,τι κατασκευάζουν τα μοντέλα τους, πιθανότατα θα συντρίψει τη νέα βιομηχανία που ανθεί. Όταν τηλεφώνησαν ο Sam Altman και οι συνιδρυτές του OpenAI

για ρύθμιση

τεχνητής νοημοσύνης, επισημοποιημένη εξαίρεση από το 230

προφανώς δεν ήταν αυτό που ήθελαν

.

Ωστόσο, κατά την άποψη του Kosseff, κάποιος πρέπει να αναλάβει την ευθύνη για την τεχνητή νοημοσύνη. “Εάν είναι κάτι που οι άνθρωποι εμπιστεύονται συνήθως για πληροφορίες και είναι μια μηχανή δυσφήμισης, κάποιος πρέπει να λογοδοτήσει γι’ αυτό”, είπε.

Ωστόσο, όπως ακριβώς οι γενικές προστασίες κάτω από το 230 μπορεί να μην έχουν πολύ νόημα για την τεχνητή νοημοσύνη, οι νόμοι για τη συκοφαντική δυσφήμιση μπορεί να μην είναι η σωστή οδός για να χαλιναγωγήσουμε την ταχέως αναπτυσσόμενη τεχνολογία. Για να κερδίσει ένας ενάγων μια υπόθεση συκοφαντικής δυσφήμισης, πρέπει γενικά να αποδείξει ότι μια δήλωση έγινε με εν γνώσει ή απερίσκεπτη αδιαφορία για την αναλήθεια της. Μπορεί όμως ένα AI να «ξέρει» κάτι; «Η πραγματική κακία έχει να κάνει με την κατάσταση του νου», σημείωσε ο Kosseff. “Πώς το δείχνεις αυτό για ένα πρόγραμμα AI;”

Στη συνέχεια, υπάρχει η αλληλεπίδραση μεταξύ χρήστη και εργαλείου. Τα προγράμματα τεχνητής νοημοσύνης παράγουν τακτικά αναλήθειες και μπορούν εύκολα να χρησιμοποιηθούν για τη δημιουργία προσβλητικού ή δυνητικά επιζήμιου περιεχομένου (π.χ.

σεξουαλικά

deepfakes

). Αναμφίβολα, αυτά τα επαναλαμβανόμενα προβλήματα οφείλονται τουλάχιστον εν μέρει στον κώδικα και την εκπαίδευσή τους στο back-end – που καθορίζονται από τις εταιρείες ή τους προγραμματιστές που διακινούν την τεχνολογία. Αλλά τα μεγάλα μοντέλα γλώσσας και οι γεννήτριες εικόνων/βίντεο παράγουν την έξοδο τους μόνο κατόπιν εντολής των ανθρώπων που πληκτρολογούν στην προτροπή. Ποιος πρέπει λοιπόν να επωμιστεί την ευθύνη όταν τα πράγματα πάνε στραβά;

Είναι ένα περίπλοκο, άλυτο ζήτημα που θα καθορίσει πολλά για το μέλλον της τεχνητής νοημοσύνης και του διαδικτύου. Αν δεν υπάρχουν απαντήσεις αυτή τη στιγμή, τουλάχιστον, κατά την άποψη του Kosseff είναι μια «πραγματικά συναρπαστική ερώτηση».