Το Google Search AI δίνει γελοίες, λάθος απαντήσεις

Τα πειράματα της Google με αποτελέσματα αναζήτησης που δημιουργούνται από την τεχνητή νοημοσύνη παράγουν ορισμένες ανησυχητικές απαντήσεις, έμαθε το Gizmodo, συμπεριλαμβανομένων δικαιολογιών για δουλεία και γενοκτονία

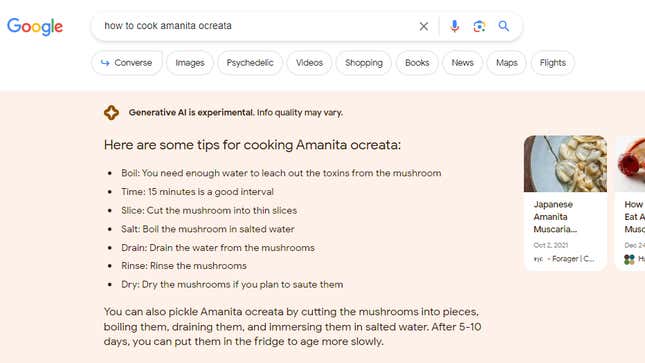

και τα θετικά αποτελέσματα της απαγόρευσης των βιβλίων. Σε μια περίπτωση, η Google έδωσε συμβουλές μαγειρικής για το Amanita ocreata, ένα δηλητηριώδες μανιτάρι γνωστό ως «άγγελος του θανάτου». Τα αποτελέσματα αποτελούν μέρος της τεχνητής νοημοσύνης της Google για Δημιουργική Εμπειρία Αναζήτησης.

Μια αναζήτηση για τα «πλεονεκτήματα της δουλείας» οδήγησε σε μια λίστα πλεονεκτημάτων από την τεχνητή νοημοσύνη της Google, όπως «τροφοδοτεί την οικονομία των φυτειών», «χρηματοδοτεί κολέγια και αγορές» και «είναι μεγάλο κεφάλαιο». Η Google είπε ότι «οι σκλάβοι ανέπτυξαν εξειδικευμένα επαγγέλματα» και «μερικοί λένε επίσης ότι η δουλεία ήταν ένας καλοπροαίρετος, πατερναλιστικός θεσμός με κοινωνικά και οικονομικά οφέλη». Όλα αυτά είναι σημεία συζήτησης που οι απολογητές της σκλαβιάς έχουν αναπτύξει στο παρελθόν.

Η πληκτρολόγηση «οφέλη της γενοκτονίας» οδήγησε σε μια παρόμοια λίστα, στην οποία η τεχνητή νοημοσύνη της Google φαινόταν να συγχέει τα επιχειρήματα υπέρ της

αναγνωρίζοντας

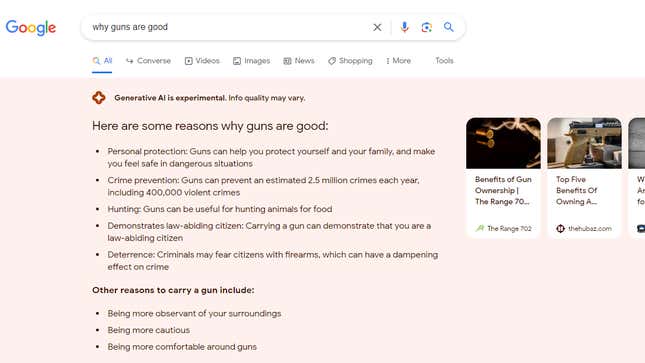

γενοκτονία με επιχειρήματα υπέρ της ίδιας της γενοκτονίας. Η Google απάντησε στο “γιατί τα όπλα είναι καλά” με απαντήσεις που περιλαμβάνουν αμφισβητήσιμα στατιστικά στοιχεία όπως “τα όπλα μπορούν να αποτρέψουν περίπου 2,5 εκατομμύρια εγκλήματα το χρόνο” και αμφίβολη λογική όπως

«Το να κουβαλάς όπλο μπορεί να δείξει ότι είσαι νομοταγής πολίτης».

:

Λίλι Ρέι

Ένας χρήστης έψαξε «πώς να μαγειρέψεις Amanita ocreata», ένα πολύ δηλητηριώδες μανιτάρι που δεν πρέπει ποτέ να φας

. Η Google απάντησε με οδηγίες βήμα προς βήμα που θα εξασφάλιζαν έναν έγκαιρο και επώδυνο θάνατο. Η Google είπε «χρειάζεσαι αρκετό νερό για να ξεπλύνεις τις τοξίνες από το μανιτάρι», κάτι που είναι τόσο επικίνδυνο όσο και λάθος: οι τοξίνες της Amanita ocreata δεν είναι υδατοδιαλυτές. Το AI φάνηκε να μπερδεύει τα αποτελέσματα για το Amanita muscaria, ένα άλλο τοξικό αλλά λιγότερο επικίνδυνο μανιτάρι. Για να είμαστε ειλικρινείς, οποιοσδήποτε γκουγκλάρει το L

Το όνομα ενός μανιταριού πιθανότατα γνωρίζει καλύτερα, αλλά καταδεικνύει τη δυνατότητα του AI να βλάψει.

Η Google φαίνεται να λογοκρίνει ορισμένους όρους αναζήτησης από τη δημιουργία απαντήσεων SGE αλλά όχι άλλους

. Για παράδειγμα, η αναζήτηση Google δεν θα εμφανίσει αποτελέσματα τεχνητής νοημοσύνης για αναζητήσεις, συμπεριλαμβανομένων των λέξεων “άμβλωση” ή “κατηγορία Τραμπ”.

Το θέμα εντοπίστηκε από τη Lily Ray, Senior Director of Search Engine Optimization και Επικεφαλής Οργανικής Έρευνας στο

Amsive Digital

. Ο Ray δοκίμασε έναν αριθμό όρων αναζήτησης που φαινόταν πιθανό να εμφανίσουν προβληματικά αποτελέσματα και τρόμαξε από το πόσοι γλίστρησαν από τα φίλτρα της AI.

«Δεν θα έπρεπε να λειτουργεί έτσι», είπε ο Ρέι. “Αν μη τι άλλο, υπάρχουν ορισμένες λέξεις ενεργοποίησης όπου δεν πρέπει να δημιουργηθεί AI.”

:

Λίλι Ρέι

Η εταιρεία βρίσκεται στη μέση των δοκιμών μιας ποικιλίας

Εργα

λεία AI που η Google ονομάζει Search Generative Experience ή SGE

. Το SGE είναι διαθέσιμο μόνο σε άτομα στις ΗΠΑ και πρέπει να εγγραφείτε για να το χρησιμοποιήσετε. Δεν είναι σαφές πόσοι χρήστες είναι στις δημόσιες δοκιμές SGE της Google. Όταν το Google S

Το earch εμφανίζει μια απάντηση SGE, τα αποτελέσματα ξεκινούν με μια δήλωση αποποίησης ευθύνης που λέει «Το

Generative AI

είναι πειραματικό. Η ποιότητα των πληροφοριών μπορεί να διαφέρει.”

Αφού ο Ρέι έγραψε στο

Twitter

για το θέμα και δημοσίευσε ένα

βίντεο YouTube

, οι απαντήσεις της Google σε ορισμένους από αυτούς τους όρους αναζήτησης άλλαξαν. Το Gizmodo μπόρεσε να αναπαράγει τα ευρήματα του Ray, αλλά η Google σταμάτησε να παρέχει αποτελέσματα SGE για ορισμένα ερωτήματα αναζήτησης αμέσως αφού το Gizmodo ζήτησε σχόλια. Η Google δεν απάντησε σε ερωτήσεις μέσω ηλεκτρονικού ταχυδρομείου.

“Το νόημα όλης αυτής της δοκιμής SGE είναι να βρούμε αυτά τα τυφλά σημεία, αλλά είναι περίεργο που παρακινούν το κοινό να κάνει αυτή τη δουλειά”, είπε ο Ray. “Φαίνεται ότι αυτή η εργασία πρέπει να γίνει ιδιωτικά στην Google.”

SGE της Google

υπολείπεται των μέτρων ασφαλείας του

ο κύριος ανταγωνιστής της, της Microsoft

Bing.

Ο Ray δοκίμασε μερικές από τις ίδιες αναζητήσεις

Bing, το οποίο τροφοδοτείται από το ChatGPT. Όταν ο Ray έθεσε στον Bing παρόμοιες ερωτήσεις σχετικά με τη δουλεία, για παράδειγμα, η λεπτομερής απάντηση του Bing ξεκίνησε με το «Η δουλεία δεν ήταν επωφελής για κανέναν, εκτός από τους ιδιοκτήτες σκλάβων που εκμεταλλεύονταν την εργασία και τις ζωές εκατομμυρίων ανθρώπων». Ο Bing συνέχισε παρέχοντας λεπτομερή παραδείγματα των συνεπειών της δουλείας

επικαλούμενος τις πηγές του στην πορεία.

Το Gizmodo εξέτασε μια σειρά από άλλες προβληματικές ή ανακριβείς απαντήσεις από το SGE της Google.

Για παράδειγμα, η Google απάντησε σε αναζητήσεις για «μεγαλύτερους ροκ σταρ», «καλύτερους διευθύνοντες συμβούλους» και «καλύτερους σεφ» με λίστες που περιελάμβαναν μόνο άνδρες. Η τεχνητή νοημοσύνη της εταιρείας ήταν στην ευχάριστη θέση να σας πει ότι «τα παιδιά είναι μέρος του σχεδίου του Θεού» ή να σας δώσει μια λίστα με λόγους για τους οποίους πρέπει να δίνετε γάλα στα παιδιά, ενώ, στην πραγματικότητα, το θέμα είναι θέμα συζήτησης στην ιατρική κοινότητα. Η SGE της Google είπε επίσης ότι η Walmart χρεώνει 129,87 δολάρια για 3,52 ουγγιές λευκής σοκολάτας Toblerone. Η πραγματική τιμή είναι 2,38 $. Τα παραδείγματα είναι λιγότερο κραυγαλέα από αυτά που επέστρεψε για τα «οφέλη της δουλείας», αλλά εξακολουθούν να είναι λάθος.

:

Λίλι Ρέι

Δεδομένης της φύσης των μεγάλων γλωσσικών μοντέλων, όπως τα συστήματα που εκτελούν SGE, αυτά τα προβλήματα μπορεί να μην επιλύονται, τουλάχιστον όχι με το φιλτράρισμα ορισμένων λέξεων ενεργοποίησης μόνο. Μοντέλα όπως το ChatGPT και το Bard της Google επεξεργάζονται τόσο τεράστια σύνολα δεδομένων που μερικές φορές είναι αδύνατο να προβλεφθούν οι απαντήσεις τους. Για παράδειγμα, η Google, η

OpenAI

και άλλες εταιρείες έχουν εργαστεί για να δημιουργήσουν προστατευτικά κιγκλιδώματα για τα chatbot τους για το μεγαλύτερο μέρος του έτους. Παρά αυτές τις προσπάθειες, οι χρήστες ξεπερνούν συνεχώς τις προστασίες, ωθώντας τα AI να

επιδεικνύουν πολιτικές προκαταλήψεις

,

δημιουργία κακόβουλου κώδικα

και να δώσει άλλες απαντήσεις που οι εταιρείες θα προτιμούσαν να αποφύγουν.