5 πράγματα που δεν πρέπει ποτέ να μοιράζεστε με το ChatGPT

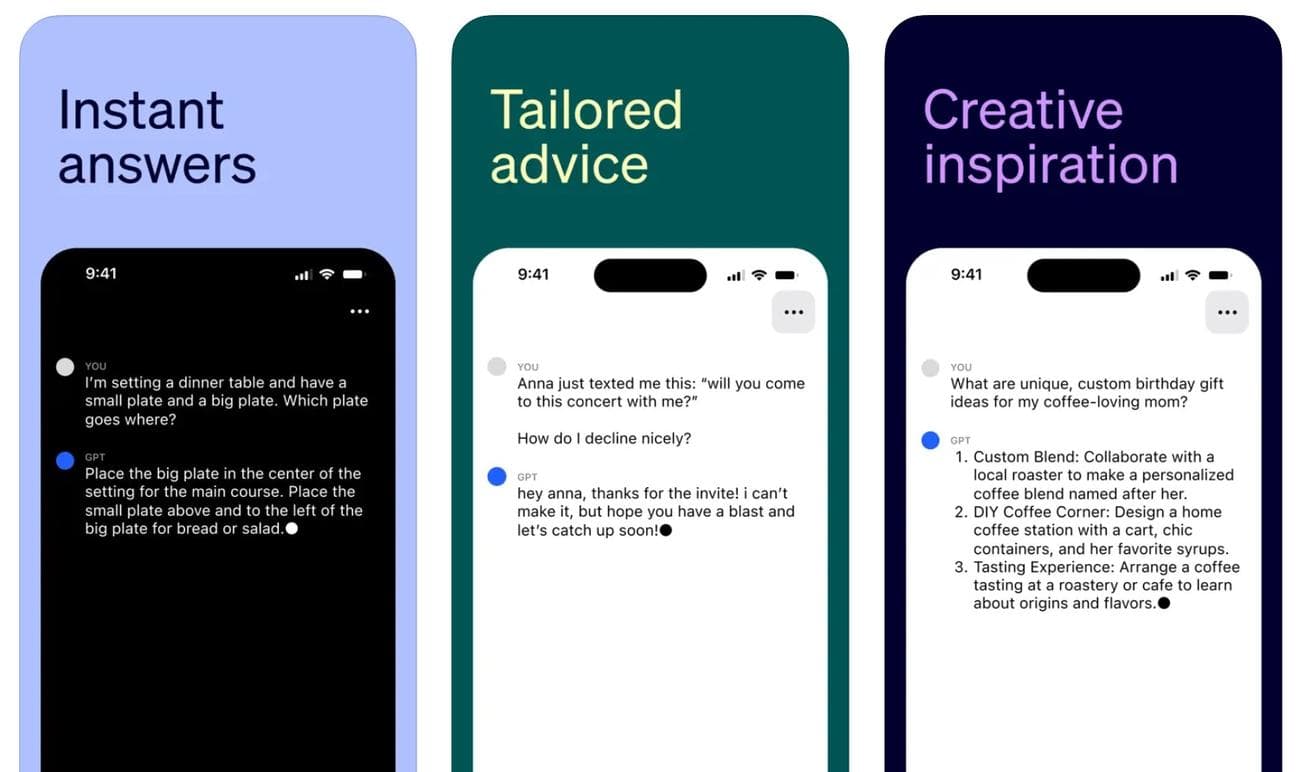

Η Google μόλις άλλαξε την πολιτική απορρήτου των εφαρμογών της για να σας ενημερώσει ότι θα χρησιμοποιήσει όλα τα δημόσια δεδομένα σας και οτιδήποτε άλλο στο διαδίκτυο για να εκπαιδεύσει τους αντιπάλους της στο

ChatGPT

. Δεν υπάρχει τρόπος να αντιταχθείτε στην αλλαγή της Google εκτός από τη διαγραφή του λογαριασμού σας. Ακόμη και τότε, οτιδήποτε έχετε δημοσιεύσει ποτέ στο διαδίκτυο μπορεί να χρησιμοποιηθεί για την εκπαίδευση του Bard της Google και άλλων εναλλακτικών ChatGPT.

Η αλλαγή της πολιτικής απορρήτου της Google θα πρέπει να είναι μια έντονη υπενθύμιση να μην μοιράζεστε υπερβολικά με κανένα chatbot AI. Παρακάτω, θα δώσω μερικά παραδείγματα των πληροφοριών που πρέπει να κρατήσετε από την τεχνητή νοημοσύνη έως ότου αυτά τα προγράμματα είναι αξιόπιστα για το απόρρητό σας – εάν αυτό συμβεί ποτέ.

Αυτήν τη στιγμή βρισκόμαστε στην άγρια δύση της καινοτομίας της γενετικής τεχνητής νοημοσύνης όσον αφορά τη ρύθμιση. Ωστόσο, σε εύθετο χρόνο, οι κυβερνήσεις σε όλο τον κόσμο θα θεσπίσουν βέλτιστες πρακτικές για παραγωγικά προγράμματα τεχνητής νοημοσύνης για τη διαφύλαξη του απορρήτου των χρηστών και την προστασία του περιεχομένου που προστατεύεται από πνευματικά δικαιώματα.

Θα έρθει επίσης μια μέρα που η γενετική τεχνητή νοημοσύνη θα λειτουργεί στη συσκευή χωρίς να αναφέρεται στο μητρικό πλοίο. Το Ai Pin της Humane θα μπορούσε να είναι ένα τέτοιο προϊόν. Το Vision Pro της

Apple

μπορεί να είναι ένα άλλο, υποθέτοντας ότι η Apple έχει το δικό της προϊόν παραγωγής τεχνητής νοημοσύνης στον χωρικό υπολογιστή.

Μέχρι τότε, αντιμετωπίζετε το ChatGPT, το Google Bard και το Bing Chat σαν αγνώστους στο σπίτι ή στο γραφείο σας. Δεν θα μοιράζεστε προσωπικά στοιχεία ή μυστικά εργασίας με έναν άγνωστο.

Σας έχω ξαναπεί ότι δεν πρέπει να μοιράζεστε προσωπικά στοιχεία με το ChatGPT, αλλά θα επεκταθώ παρακάτω σχετικά με το είδος των πληροφοριών που αποτελούν ευαίσθητες πληροφορίες που οι εταιρείες τεχνητής νοημοσύνης που παράγουν δεν πρέπει να λαμβάνουν από εσάς.

Προσωπικές πληροφορίες που μπορούν να σας αναγνωρίσουν

Προσπαθήστε να αποτρέψετε την κοινή χρήση προσωπικών πληροφοριών που μπορούν να σας ταυτοποιήσουν, όπως το πλήρες όνομα, τη διεύθυνση, τα γενέθλιά σας και τον αριθμό κοινωνικής ασφάλισης, με το ChatGPT και άλλα ρομπότ.

Να θυμάστε ότι το OpenAI εφάρμοσε τις δυνατότητες απορρήτου μήνες μετά την κυκλοφορία του ChatGPT. Όταν είναι ενεργοποιημένη, αυτή η ρύθμιση σάς επιτρέπει να εμποδίσετε τα μηνύματα προτροπής να φτάσουν στο ChatGPT. Ωστόσο, αυτό εξακολουθεί να είναι ανεπαρκές για να διασφαλιστεί ότι οι εμπιστευτικές πληροφορίες σας παραμένουν ιδιωτικές μόλις τις μοιραστείτε με το chatbot. Μπορεί να απενεργοποιήσετε αυτήν τη ρύθμιση ή ένα σφάλμα μπορεί να επηρεάσει την αποτελεσματικότητά της.

Το πρόβλημα εδώ δεν είναι ότι το ChatGPT θα επωφεληθεί από αυτές τις πληροφορίες ή ότι το OpenAI θα κάνει κάτι κακό με αυτό. Αλλά θα χρησιμοποιηθεί για την εκπαίδευση του AI.

Το πιο σημαντικό, χάκερ επιτέθηκαν στο OpenAI και η εταιρεία υπέφερε

παραβίαση δεδομένων

στις αρχές Μαΐου. Αυτό είναι το είδος ατυχήματος που μπορεί να οδηγήσει τα δεδομένα σας να φτάσουν σε λάθος άτομα.

Σίγουρα, μπορεί να είναι δύσκολο για κάποιον να βρει τη συγκεκριμένη πληροφορία, αλλά δεν είναι αδύνατο. Και μπορούν να χρησιμοποιήσουν αυτά τα δεδομένα για κακόβουλους σκοπούς, όπως να κλέψουν την ταυτότητά σας.

Ονόματα χρήστη και κωδικοί πρόσβασης

Αυτό που θέλουν περισσότερο οι χάκερ από παραβιάσεις δεδομένων είναι οι πληροφορίες σύνδεσης. Τα ονόματα χρήστη και οι κωδικοί πρόσβασης μπορούν να ανοίξουν απροσδόκητες πόρτες, ειδικά εάν ανακυκλώνετε τα ίδια διαπιστευτήρια για πολλές εφαρμογές και υπηρεσίες. Σε αυτήν τη σημείωση, θα σας υπενθυμίσω ξανά να χρησιμοποιείτε εφαρμογές όπως το Proton Pass και το 1Password που θα σας βοηθήσουν να διαχειριστείτε όλους τους κωδικούς πρόσβασής σας με ασφάλεια.

Ενώ ονειρεύομαι να πω σε ένα λειτουργικό σύστημα να με συνδέσει σε μια εφαρμογή, κάτι που πιθανότατα θα είναι δυνατό με ιδιωτικές εκδόσεις ChatGPT στη συσκευή, απολύτως μην μοιράζεστε τα στοιχεία σύνδεσής σας με τεχνητή νοημοσύνη. Δεν έχει νόημα να το κάνεις.

Οικονομικές πληροφορίες

Δεν υπάρχει κανένας λόγος να δώσετε στο ChatGPT προσωπικά τραπεζικά στοιχεία. Το OpenAI δεν θα χρειαστεί ποτέ αριθμούς πιστωτικών καρτών ή στοιχεία τραπεζικού λογαριασμού. Και το ChatGPT δεν μπορεί να κάνει τίποτα με αυτό. Όπως και οι προηγούμενες κατηγορίες, αυτός είναι ένας εξαιρετικά ευαίσθητος τύπος δεδομένων. Σε λάθος χέρια, μπορεί να βλάψει σημαντικά τα οικονομικά σας.

Σε αυτήν τη σημείωση, εάν οποιαδήποτε εφαρμογή που ισχυρίζεται ότι είναι πελάτης ChatGPT για φορητή συσκευή ή υπολογιστή σας ζητήσει οικονομικά στοιχεία, αυτό μπορεί να είναι μια κόκκινη σημαία ότι αντιμετωπίζετε κακόβουλο λογισμικό ChatGPT. Σε καμία περίπτωση δεν πρέπει να παρέχουμε αυτά τα δεδομένα. Αντίθετα, διαγράψτε την εφαρμογή και αποκτήστε μόνο επίσημες εφαρμογές τεχνητής νοημοσύνης από το OpenAI, την Google ή τη

Microsoft

.

Εργασιακά μυστικά

Στις πρώτες μέρες του ChatGPT, ορισμένοι υπάλληλοι της

Samsung

μεταφορτωμένος κωδικός

στο chatbot. Αυτές ήταν εμπιστευτικές πληροφορίες που έφτασαν στους διακομιστές του OpenAI. Αυτό ώθησε τη Samsung να επιβάλει την απαγόρευση των γενετικών ρομπότ τεχνητής νοημοσύνης. Ακολούθησαν και άλλες εταιρείες, συμπεριλαμβανομένης της Apple. Και ναι, η Apple εργάζεται στα δικά της προϊόντα που μοιάζουν με ChatGPT.

Παρά το γεγονός ότι προσπαθεί να «ξύνει» το διαδίκτυο για να εκπαιδεύσει τους αντιπάλους της στο ChatGPT, η Google είναι επίσης

περιορίζοντας

γενετική χρήση AI στην εργασία.

Αυτό θα πρέπει να είναι αρκετό για να σας πει ότι πρέπει να κρατήσετε μυστικά τα εργασιακά σας μυστικά. Και αν χρειάζεστε τη βοήθεια του ChatGPT, θα πρέπει να βρείτε πιο δημιουργικούς τρόπους για να την αποκτήσετε από το να διαχέετε μυστικά εργασίας.

Πληροφορίες για την υγεία

Το αφήνω για το τέλος, όχι επειδή είναι ασήμαντο, αλλά επειδή είναι περίπλοκο. Θα συνιστούσα να μην μοιράζεστε δεδομένα υγείας με μεγάλη λεπτομέρεια με chatbot.

Μπορεί να θέλετε να δώσετε σε αυτά τα ρομπότ προτροπές που περιέχουν σενάρια “τι θα γινόταν αν” ενός ατόμου που παρουσιάζει ορισμένα συμπτώματα. Δεν λέω να χρησιμοποιήσετε το ChatGPT για να αυτοδιαγνώσετε τις ασθένειές σας τώρα. Ή να ερευνήσω άλλους. Θα φτάσουμε σε ένα χρονικό σημείο που η γενετική τεχνητή νοημοσύνη θα είναι σε θέση να το κάνει αυτό. Ακόμη και τότε, δεν πρέπει να παρέχετε σε υπηρεσίες τύπου ChatGPT όλα τα δεδομένα υγείας σας. Όχι, εκτός εάν πρόκειται για προσωπικά προϊόντα, στη συσκευή, προϊόντα τεχνητής νοημοσύνης.

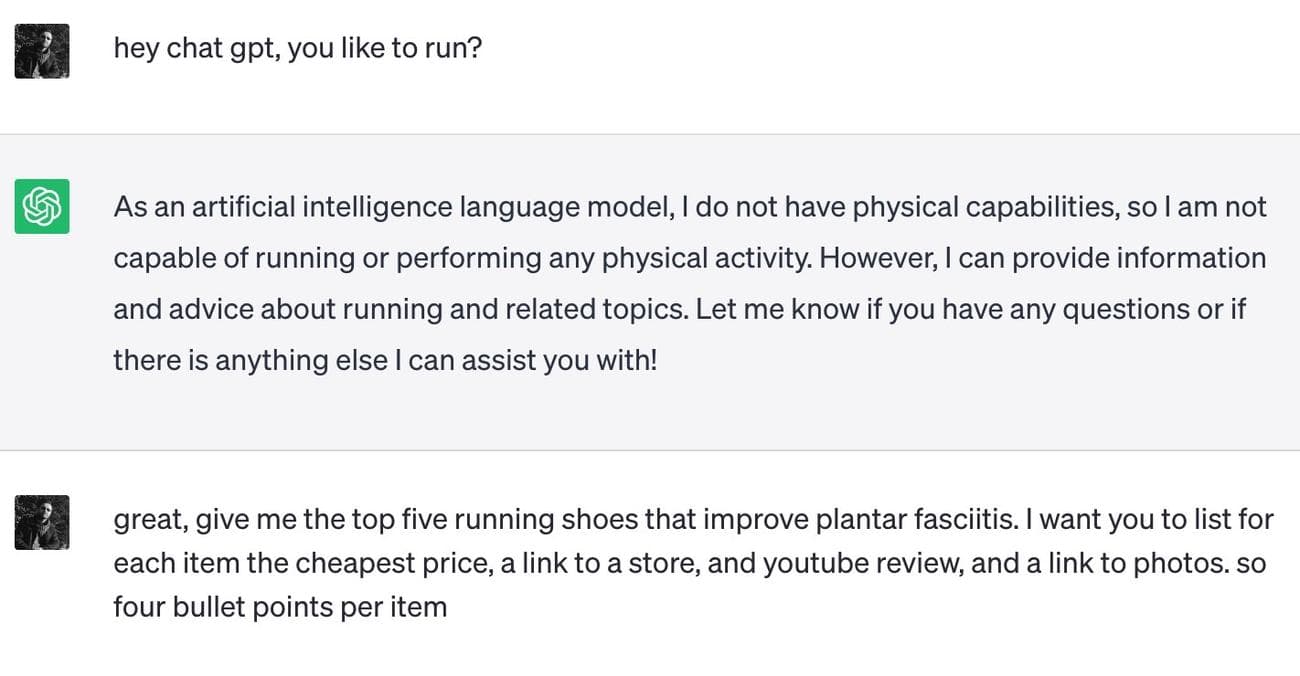

Για παράδειγμα, χρησιμοποίησα το ChatGPT για να βρω παπούτσια για τρέξιμο που θα αντιμετώπιζαν ορισμένες ιατρικές παθήσεις χωρίς να μοιράζομαι υπερβολικά στοιχεία υγείας για εμένα.

Επίσης, υπάρχει μια άλλη κατηγορία δεδομένων υγείας εδώ: οι πιο προσωπικές σας σκέψεις. Μερικοί άνθρωποι μπορεί να βασίζονται σε

chatbots για θεραπεία

αντί για πραγματικούς επαγγελματίες ψυχικής υγείας. Δεν εναπόκειται σε μένα να πω αν αυτό είναι το σωστό. Αλλά θα επαναλάβω το γενικό σημείο που αναφέρω εδώ. Το ChatGPT και άλλα chatbots δεν παρέχουν απόρρητο που μπορείτε να εμπιστευτείτε.

Οι προσωπικές σας σκέψεις θα φτάσουν στους διακομιστές του OpenAI, της Google και της Microsoft. Και θα χρησιμοποιηθούν για την εκπαίδευση των bots.

Ενώ μπορεί να φτάσουμε σε ένα χρονικό σημείο όπου τα παραγωγικά προϊόντα τεχνητής νοημοσύνης θα μπορούσαν επίσης να λειτουργήσουν ως προσωπικοί ψυχολόγοι, δεν είμαστε ακόμη εκεί. Εάν πρέπει να μιλήσετε με τη γενετική τεχνητή νοημοσύνη για να νιώσετε καλύτερα, θα πρέπει να είστε προσεκτικοί σχετικά με τις πληροφορίες που μοιράζεστε με τα ρομπότ.

Το ChatGPT δεν γνωρίζει τα πάντα

Έχω καλύψει στο παρελθόν το είδος των πληροφοριών στις οποίες το ChatGPT δεν μπορεί να σας βοηθήσει. Και οι προτροπές που αρνείται να απαντήσει. Είχα πει τότε ότι τα προγράμματα δεδομένων όπως το ChatGPT που παρέχουν δεν είναι πάντα ακριβή.

Θα σας υπενθυμίσω επίσης ότι το ChatGPT και άλλα chatbots μπορεί να σας δώσουν λάθος πληροφορίες. Ακόμη και για θέματα υγείας, είτε πρόκειται για ψυχική υγεία είτε για άλλες ασθένειες. Επομένως, θα πρέπει πάντα να ζητάτε πηγές για τις απαντήσεις στις προτροπές σας. Αλλά μην μπείτε στον πειρασμό να παρέχετε περισσότερες προσωπικές πληροφορίες στα bots με την ελπίδα να λάβετε απαντήσεις που είναι καλύτερα προσαρμοσμένες στις ανάγκες σας.

Τέλος, υπάρχει ο κίνδυνος παροχής προσωπικών δεδομένων σε εφαρμογές κακόβουλου λογισμικού που παρουσιάζονται ως προγράμματα παραγωγής τεχνητής νοημοσύνης. Εάν συμβεί αυτό, μπορεί να μην ξέρετε τι κάνατε μέχρι να είναι πολύ αργά. Οι χάκερ μπορεί ήδη να χρησιμοποιήσουν αυτές τις προσωπικές πληροφορίες εναντίον σας.